Ihre geschäftlichen Ziele zu verstehen

und Ihre Projektvorteile zu maximieren

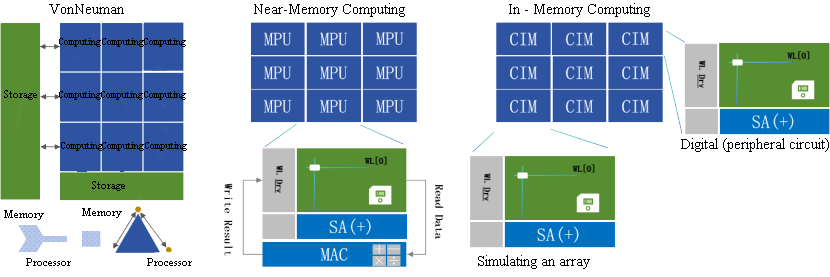

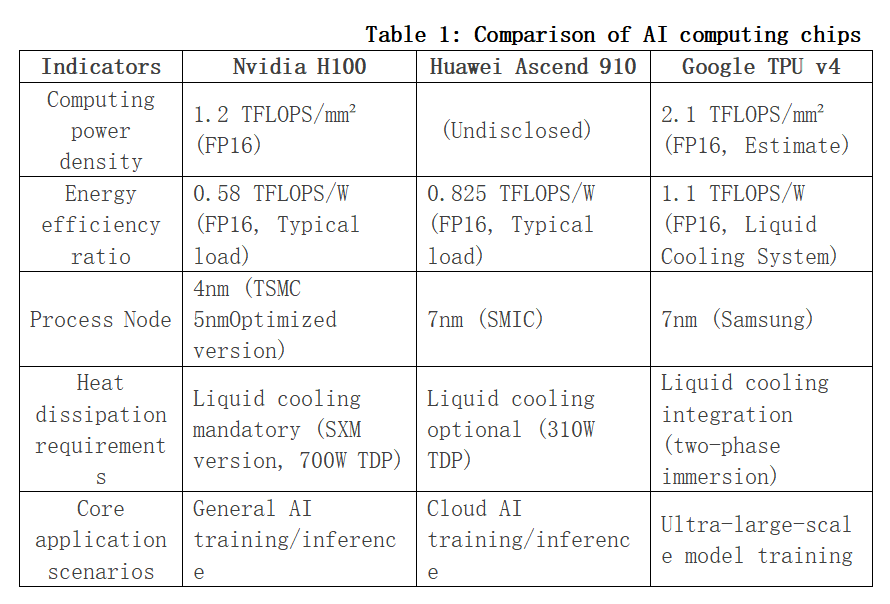

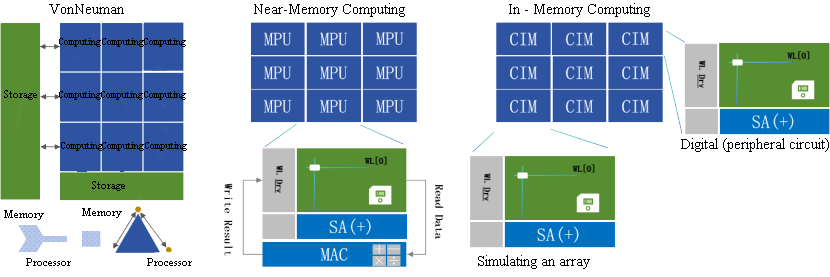

Auf dem Weg zu Exascale-AI-Rechenleistung sind Huaweis CloudMatrix 384 Super-Node und NVIDIAs GB200 NVL72 Cluster zu zwei weltweit beachteten technologischen Gipfeln geworden. Sie repräsentieren nicht nur unterschiedliche Hardware-Integrationsfähigkeiten, sondern offenbaren tiefgreifend zwei grundlegende Philosophien zum Aufbau von Supercomputing-Systemen.

Der eine Ansatz wird als "kontinuierliches hohes Fieber" metaphorisch beschrieben und steht vor der extremen thermischen Herausforderung, die unter der stabilen Betriebslast von 384 dicht gepackten Chips entsteht. Der andere wird als "intermittierende Epilepsie" charakterisiert und muss heftige, gepulste Wärmeströme bändigen, die entstehen, wenn 72 Top-GPUs synchron arbeiten. Diese unterschiedlichen "Krankheitsbilder" führen letztendlich zu völlig unterschiedlichen "Therapien" – also Kühllösungen – und veranschaulichen klar zwei zentrale Ingenieurphilosophien: Das Duell zwischen deterministischer Systemtechnik und agiler Ökosystem-Innovation. Für jedes Unternehmen in der Lieferkette ist das Verständnis dieses Duells der Schlüssel zur Definition der eigenen künftigen Rolle.

1- Die Ursache des Kernunterschieds – Die "Diagnose" bestimmt die "Therapie"

Am Ausgangspunkt des Designs schlugen Huawei und NVIDIA unterschiedliche Wege ein, was ihre jeweiligen Wärmequellen-Charakteristiken direkt prägte:

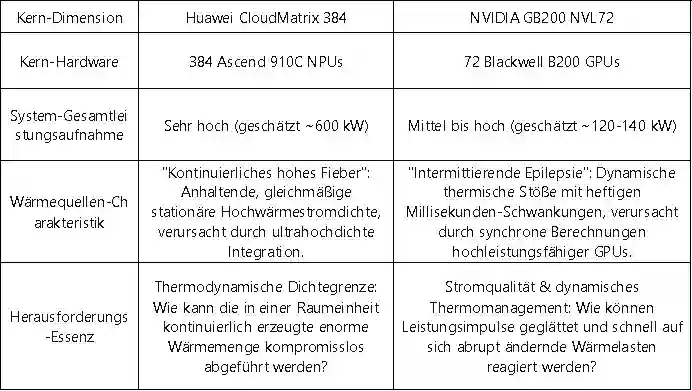

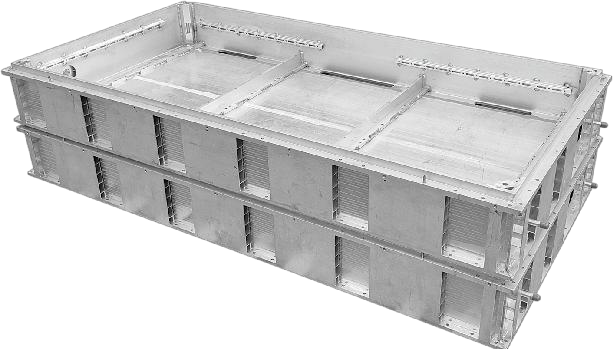

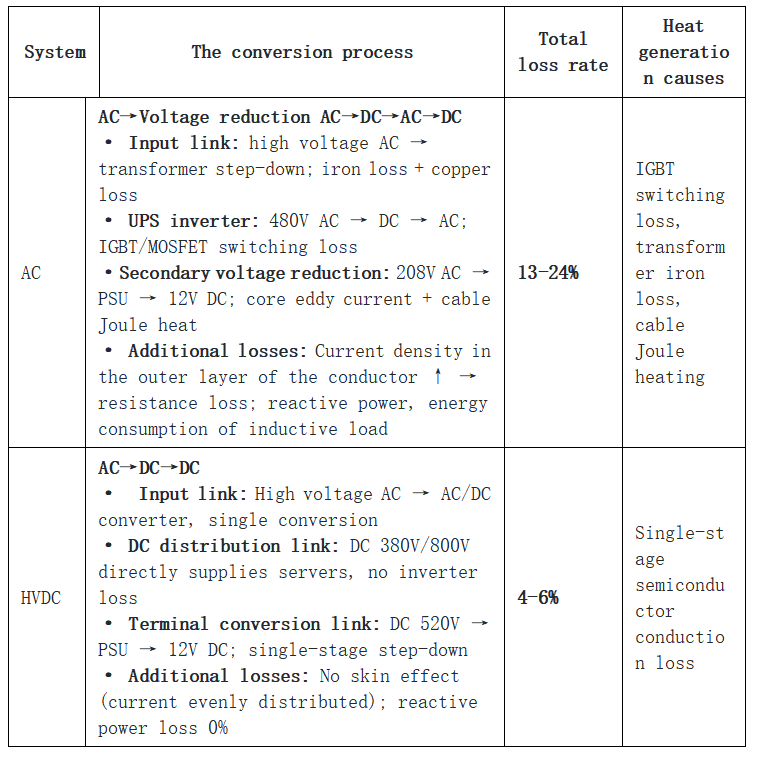

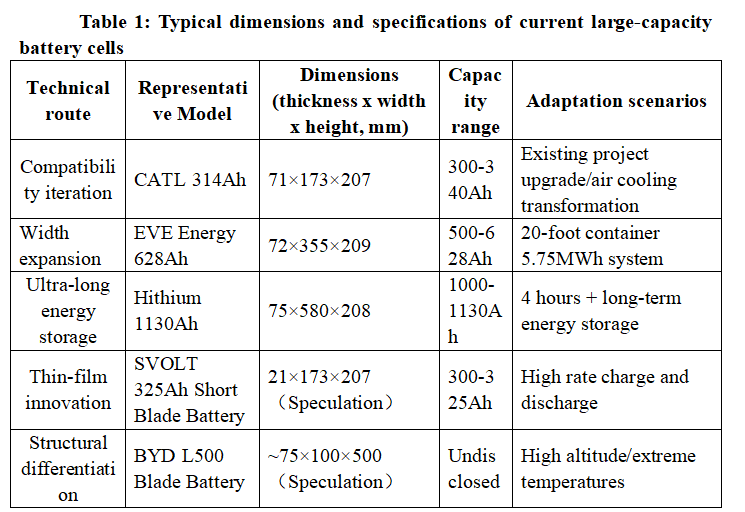

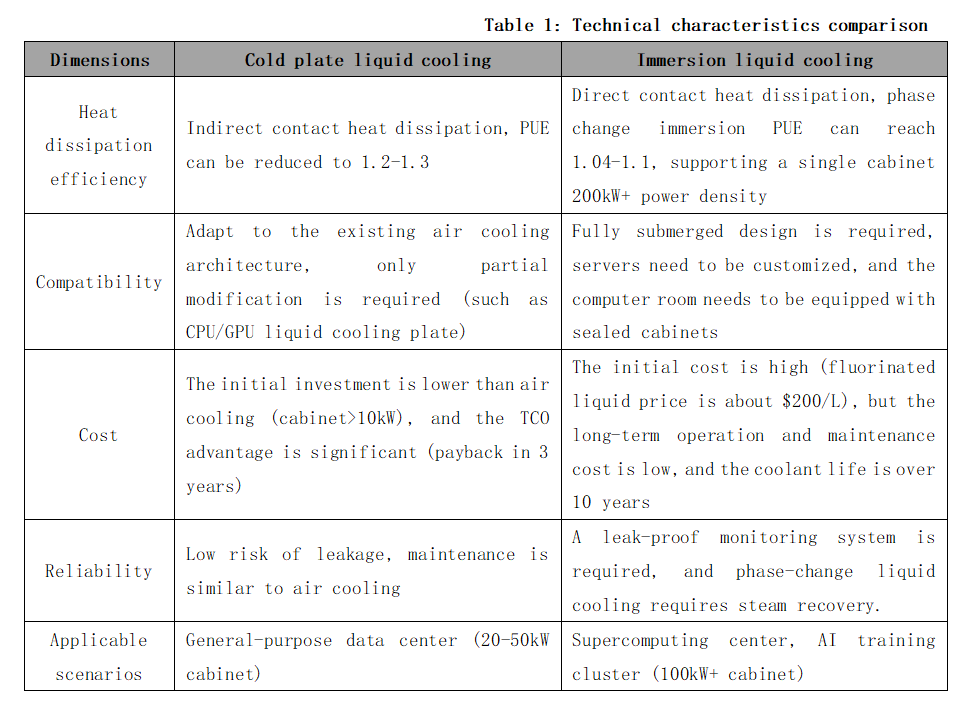

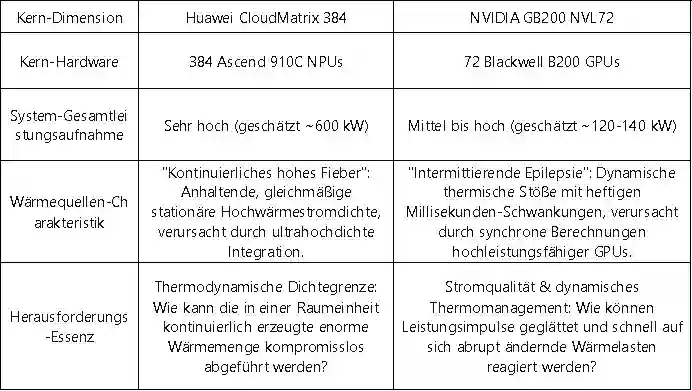

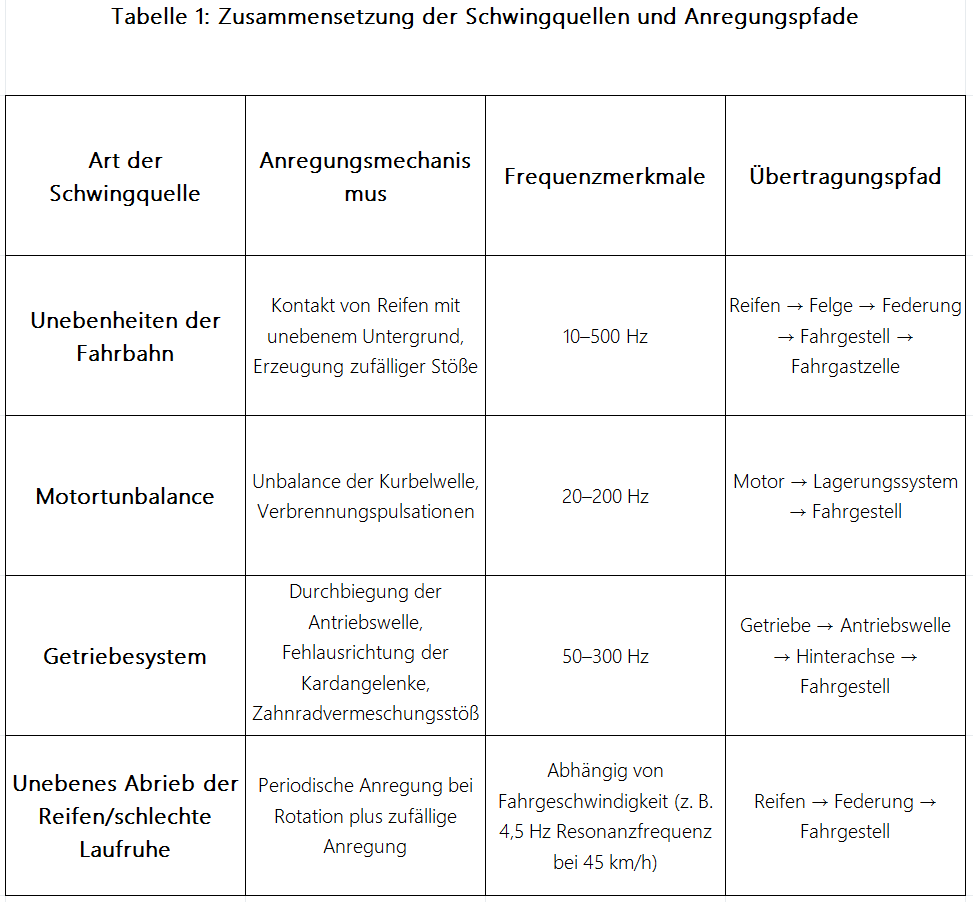

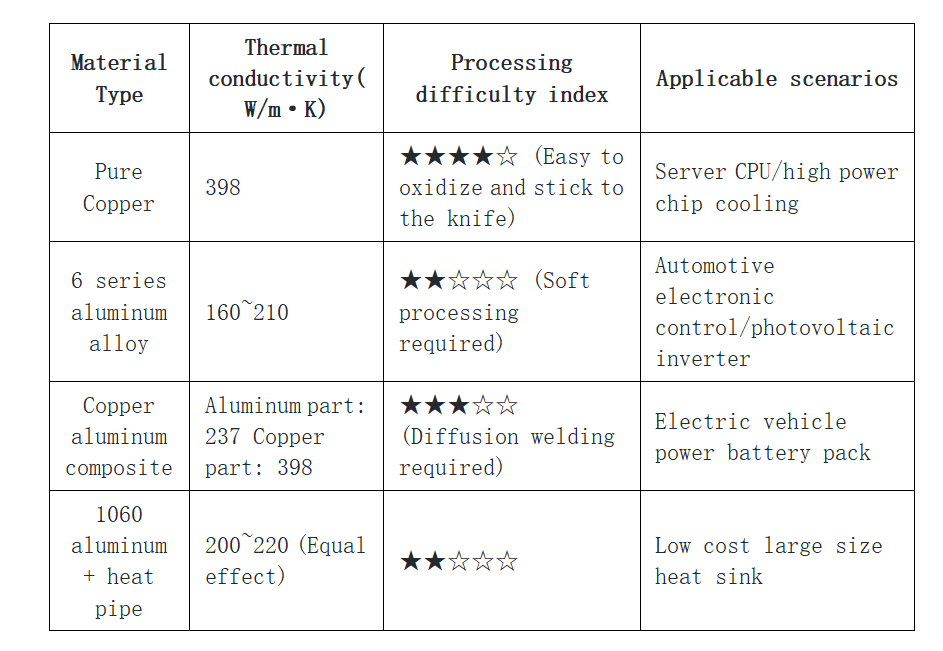

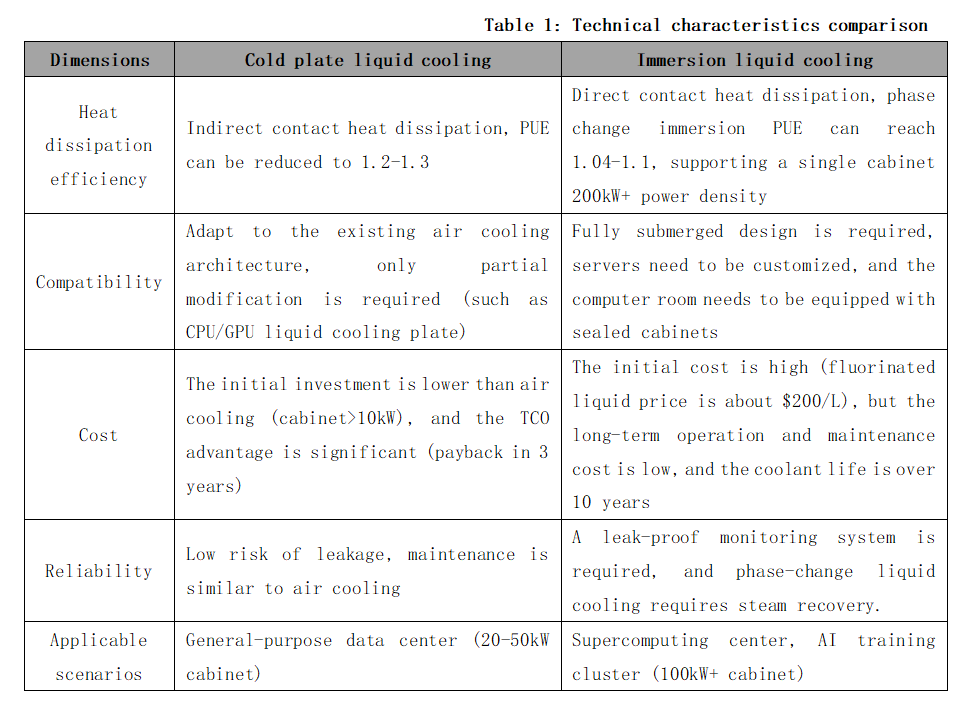

Tabelle 1: Vergleich der Wärmequellen-Charakteristika der beiden technologischen Pfade

Dieser Unterschied zwischen "kontinuierlichem hohen Fieber" und "intermittierender Epilepsie" ist keineswegs zufällig. Er spiegelt wider, dass Huawei als Herausforderer beschlossen hat, die Gesamtsystemleistung als Kernziel anzugehen und um jeden Preis den Durchbruch zur maximal möglichen Rechendichte in einem einzigen Rack zu schaffen. NVIDIA hingegen, als etablierter Marktführer, hat die Aufgabe, ein effizient zusammenarbeitendes und leicht zu verbreitendes Ökosystem aufzubauen, während es gleichzeitig den absoluten Leistungsvorsprung seiner Einzelchips sicherstellt.

2- Die Materialisierung der Ingenieurphilosophie – Zwei Pfade der Flüssigkühlung

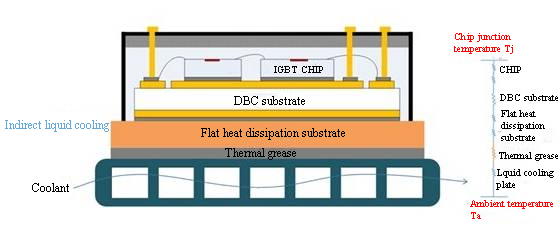

Die beiden unterschiedlichen Designphilosophien manifestieren sich am deutlichsten in den entscheidenden Flüssigkühlungslösungen und prägen den gesamten Technologiestack vom Chip bis zum Rechenzentrumsraum.

a. Huawei: Die Flüssigkühlungspraxis deterministischer Systemtechnik

Dies ist eine von oben nach unten umgesetzte Designphilosophie, die für das systemweite Ziel der Deterministik geschaffen wurde. Ihr Kern liegt darin, die Wärmeabfuhr nicht nur als Zubehör, sondern als kritischen Teil der Infrastruktur ganzheitlich, integriert und mit hoher Zuverlässigkeit zu realisieren.

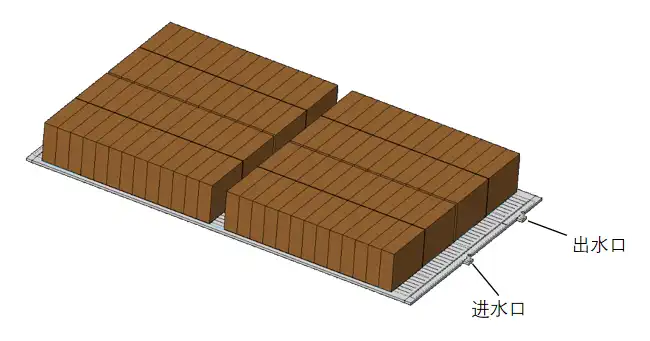

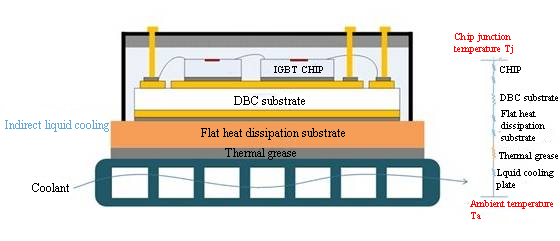

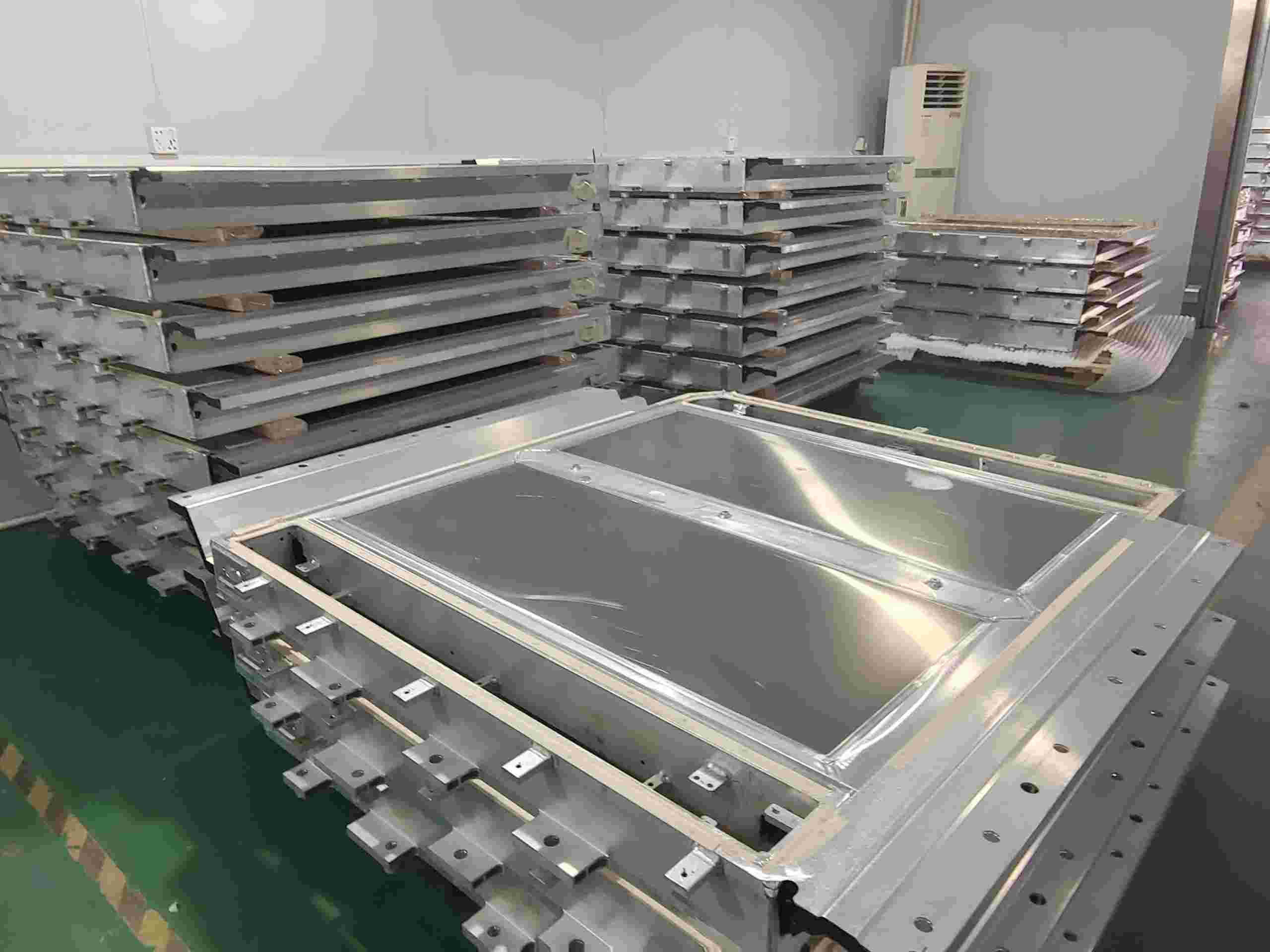

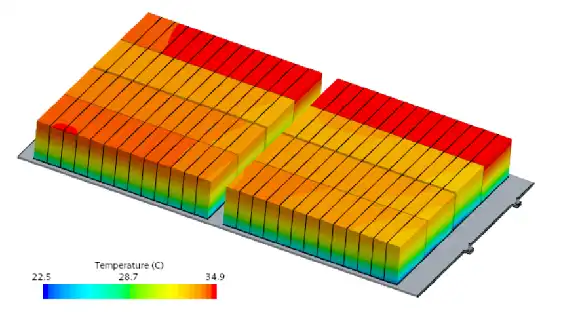

Abbildung 1: Huawei Ascend 384 Super-Node

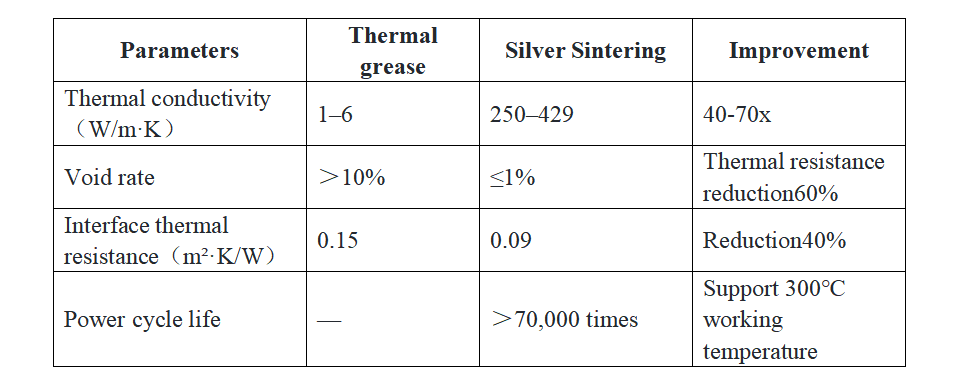

· Chip-Level-Präzision und zuverlässige Verbindung: Um die effiziente Wärmeübertragung vom Chip zum Kühlkörper zu gewährleisten, konzentriert sich Huawei auf die technische Optimierung der Grenzflächenmaterialien. Obwohl öffentliche Dokumente zeigen, dass das Unternehmen in diesem Bereich (z.B. mit hochsphärischen Siliziumkarbid-Füllstoffen) über wegweisende Patentreserven verfügt, sind die konkreten Anwendungsdetails im Super-Node nicht öffentlich. Sicher ist, dass deren Lösung extrem niedrige Grenzflächenwiderstände und langfristige Zuverlässigkeit für die Herausforderung des "kontinuierlichen hohen Fiebers" anstrebt.

· System-Level-Redundanz und intelligente Steuerung: Es werden redundante Designs wie z.B. ringförmige Flüssigkeitsversorgung eingesetzt, und ein eigenentwickelter Flüssigkühlungs- und Wärmemanagement-Controller (TMU) fungiert als systemischer "Schaltzentrale". Dieser Controller ermöglicht eine unterbrechungsfreie (0-Sekunden) Umschaltung zwischen Leitungen und nutzt KI für Fehlervorhersagen. Auf diese Weise gewährleistet er durch softwaredefinierte Ansätze die Deterministik und Zuverlässigkeit der Wärmeabfuhrkette – ein typisches Beispiel für systemtechnisches Denken.

· Infrastruktur-Integration ("Kälte-Strom-Fusion"): Auf Rack-Ebene werden die Flüssigkühlungs-Verteilungseinheit (CDU) und die Hochspannungs-Stromverteilungseinheit (PDU) physikalisch integriert und einheitlich verwaltet. Dieses "integrierte Kühl- und Stromdesign" ist die ultimative technische Antwort auf extrem hohe Leistungsdichten pro Rack, die Vereinfachung der Bereitstellung und die Verbesserung der Energieeffizienz (Senkung des PUE). Es verkörpert die physische Umsetzung des deterministischen Designs vom Konzept zur realen Form.

b. NVIDIA: Der Flüssigkühlungsrahmen agiler Ökosystem-Innovation

Dies ist eine Designphilosophie, die den GPU-Kern in den Mittelpunkt stellt und durch die Definition offener Standards das globale Ökonomie befähigt. Ihr Kern liegt darin, einen validierten "Bauplan" bereitzustellen, der die Anwendungsschwelle für die gesamte Branche senkt und effiziente, flexible Skalierbarkeit ermöglicht.

· Chip-Level-Standardisierung und Referenzdesign (VRD): NVIDIA stellt für seine GPUs (z.B. die Blackwell-Serie) detaillierte thermische Referenzdesigns bereit, die physikalische Abmessungen des Kühlkörpers, die thermische Verlustleistung (TDP), Durchflussmenge, Druckverlust und andere Leistungsschnittstellen klar definieren. Dies liefert allen Kühlungsherstellern eine "Standardantwort", kapselt die Komplexität in Standardkomponenten und sichert so Kompatibilität und eine qualitative Grundlinie für die Basiskomponenten.

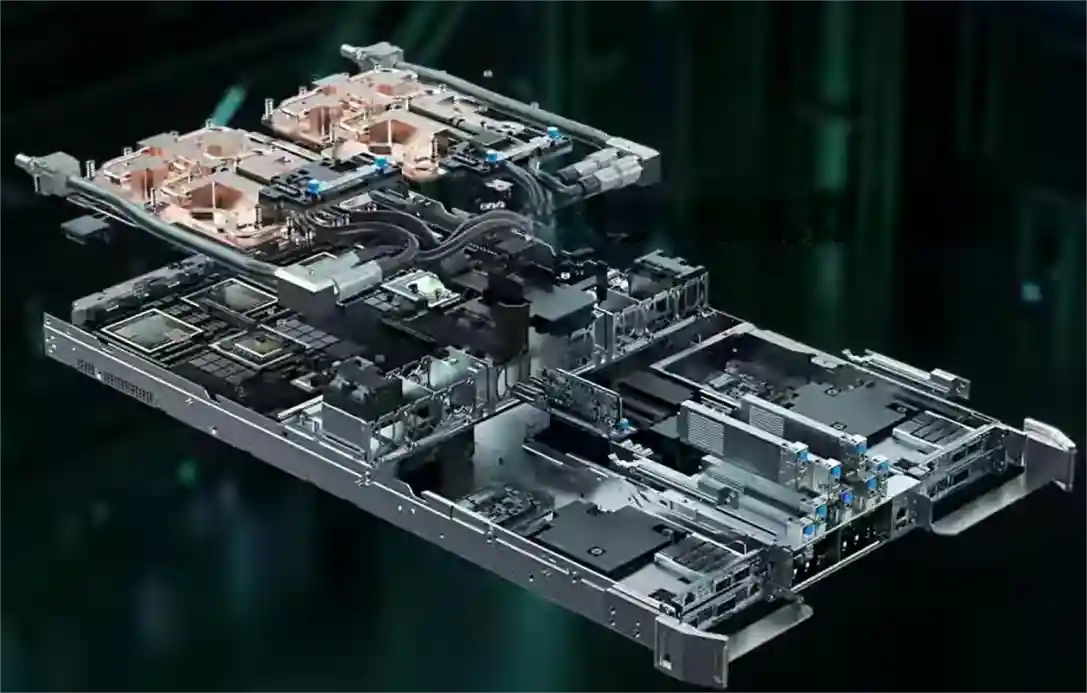

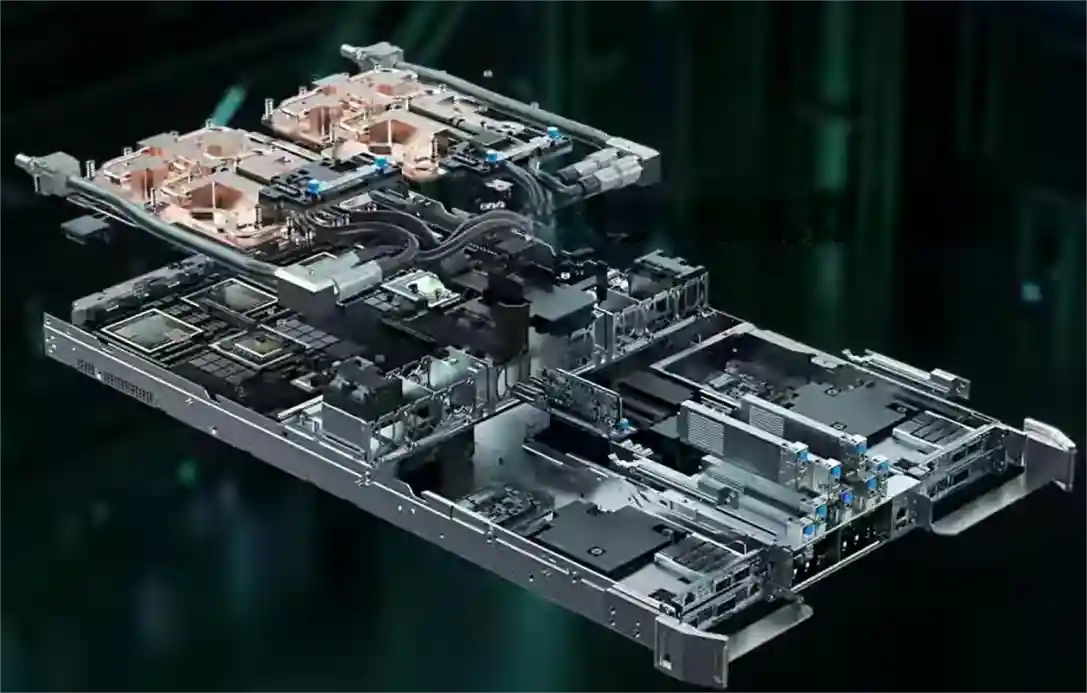

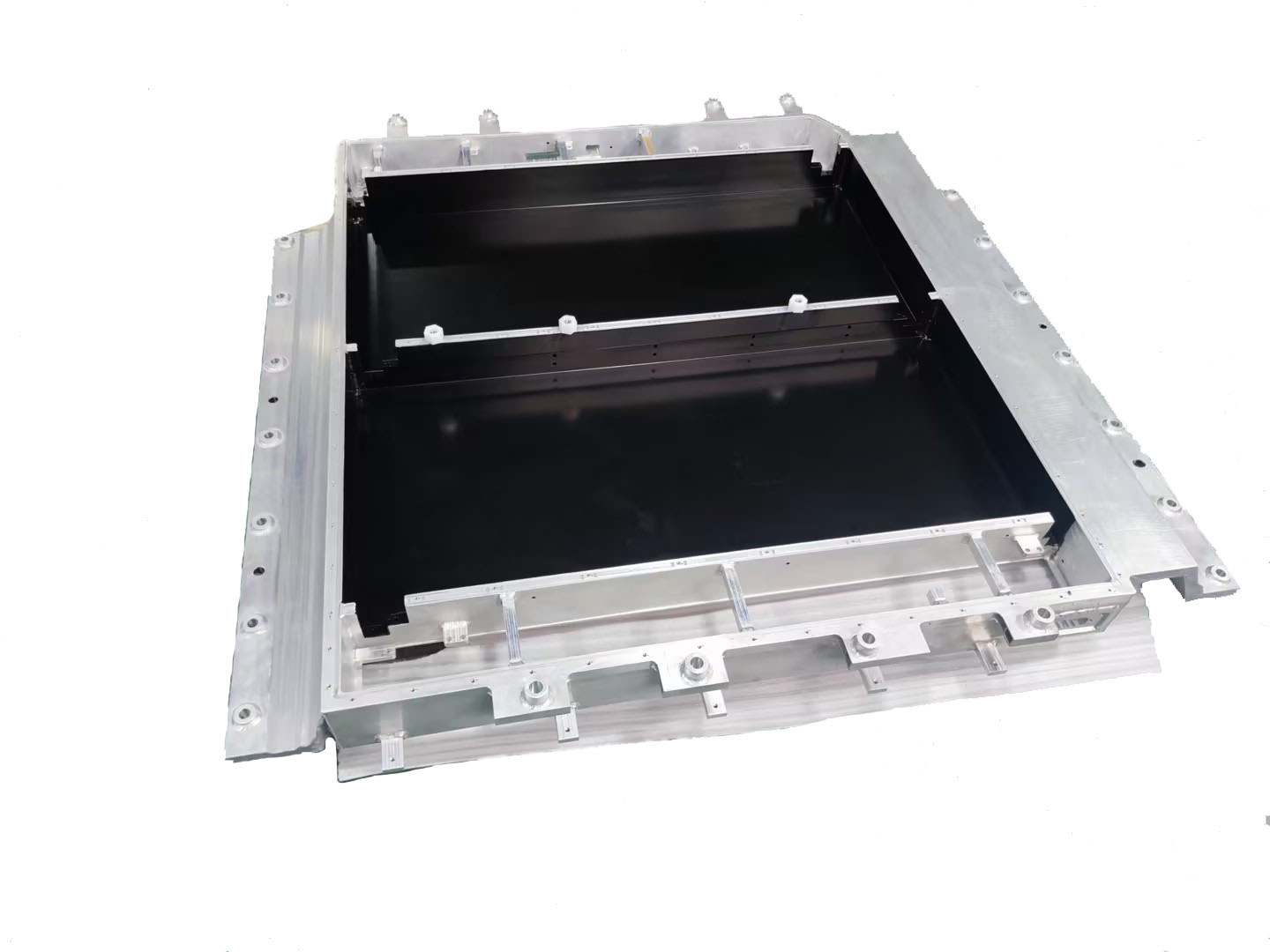

Abbildung 2: NVIDIA Server-Modul und Mikrokanal-Flüssigkühlkörper

· Ökosystem-Level-Kollaboration und Lösungszertifizierung: Enge Zusammenarbeit mit führenden Wärmemanagement- und Infrastrukturanbietern wie Vertiv und Boyd zur gemeinsamen Entwicklung und Zertifizierung von Rack-Level-Flüssigkühlungslösungen. Beispielsweise ist Vertivs "Tier 2 Ready"-Rack-Lösung ein vorab validiertes Produkt, das auf dem NVIDIA-Bauplan basiert. Sie ermöglicht es Rechenzentrumsbetreibern, Flüssigkühlungscluster wie Standardgeräte zu beschaffen und schnell einsatzbereit zu erhalt en.

· Digitaler Zwilling und beschleunigte Bereitstellung: Über die NVIDIA Omniverse-Plattform werden digitale Zwillinge und Simulationstools für Rechenzentrums-Flüssigkühlungssysteme bereitgestellt. Kunden können Kühllösungen in einer virtuellen Umgebung entwerfen, validieren und optimieren, was die Kosten und Risiken physischer Validierung erheblich reduziert und den Prozess von der Entwicklung bis zur Bereitstellung agil gestaltet.

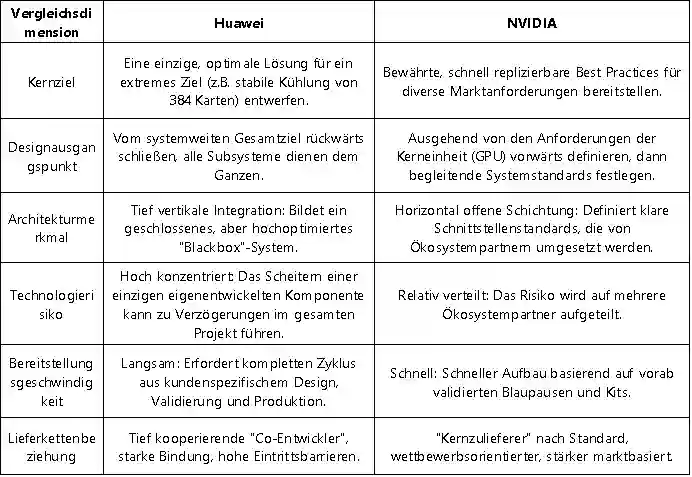

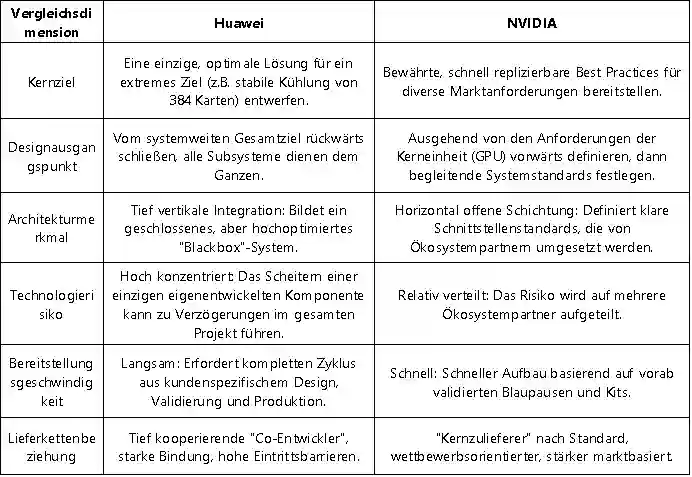

Um diese beiden Pfade klarer zu verstehen, sind deren Kernunterschiede hier gegenübergestellt:

Tabelle 2: Huawei-Modell vs. NVIDIA-Modell: Überblick der Schlüsselunterschiede

3- Die Lehren der Geschichte und die künftige Konvergenz

Der Wettbewerb zwischen diesen beiden Pfaden ist in der Technologiegeschichte kein Einzelfall. Im Kern handelt es sich um eine weitere klassische Ausprägung des Gegensatzes zwischen systemintegrativer Innovation und plattformökologischer Innovation. Huawei ähnelt dem Apple der Steve-Jobs-Ära, indem es nach absoluter Kontrolle über das Produkterlebnis von der obersten bis zur untersten Ebene strebt. NVIDIA hingegen ähnelt eher dem heutigen Google Android, indem es durch die Festlegung von Kernstandards (Android-System/GPU-Architektur) den Wohlstand des gesamten Ökosystems antreibt.

Für die Branche liegt der künftige Trend wahrscheinlich nicht in der vollständigen Verdrängung des einen durch den anderen Ansatz, sondern in einer gewissen Konvergenz:

· Bei nationalen oder unternehmenskritischen Projekten, die extreme Rechenleistung anstreben, bleibt der Reiz des deterministischen Systemengineering ungebrochen.

· Im breiten kommerziellen Cloud-Computing-Markt wird sich die agile Ökosystem-Innovation aufgrund ihrer Geschwindigkeits- und Kostenvorteile weiter ausdehnen.

· Der funkelnde Funke der Erkenntnis könnte in der Schnittmenge entstehen: der Integration tieferer Maßschneiderung und kooperativer Optimierung in offene Ökosystem-Standards.

4- Schlussfolgerung

Der Wettstreit zwischen Huawei und NVIDIA im Bereich der Wärmeabfuhr ist daher im Wesentlichen ein Aufeinandertreffen zweier Kernkompetenzen im KI-Zeitalter: Die eine Seite strebt durch tiefe Integration von Systemtechnik nach deterministischer, maximaler Leistung. Die andere Seite treibt durch den Aufbau offener Standards und eines Ökosystems die agile Innovation und schnelle Verbreitung in der Industrie voran. Dieses Duell zeichnet den Teilnehmern in der Lieferkette klare Pfade vor: Sollen sie als "Spezialeinheit" tiefe Bindungen eingehen und konkrete, systemweite Festungen erobern? Oder als "Hauptarmee" in das Ökosystem eintreten und auf der weiten Ebene der Standards Märkte erschließen? Letztendlich hängt der Ausgang nicht nur von der Technologie selbst ab, sondern noch mehr vom Einblick in die Entwicklungslogik der Industrie und von der klaren Definition der eigenen Position in der künftigen Landkarte.

Wir werden regelmäßig Informationen und Technologien zu Wärmedesign und Leichtbau aktualisieren und mit Ihnen teilen. Vielen Dank für Ihr Interesse an Walmate.

Wenn die „Größe“ der Batteriezelle zum Konsens wird, wird die „Stärke“ des Packs zum neuen Schlachtfeld

Die Energiespeicherbranche erlebt einen Sprung bei der Zellkapazität – der Wechsel von 280Ah hin zu 500Ah+ ist bereits Realität. Während sich die Branche auf die „Größe“ der Zelle konzentriert, rückt die „Stärke“ des Packs – also seine mechanische Tragfähigkeit und Fähigkeit zur Sicherheitsbeherrschung – in den Fokus des Wettbewerbs. Unabhängig davon, wie sich die Chemie oder Kapazität der Zelle entwickelt, müssen deren Ausdehnungskräfte, thermische Durchgehen-Energie und mechanische Lasten letztlich vom Untergehäuse des Packs, der mechanischen Basis, getragen werden.

Dieser Artikel beleuchtet aus der Perspektive des Strukturdesigns, wie das Untergehäuse des Packs differenzierten mechanischen und thermischen Anforderungen angesichts divergierender Zelltechnologiepfade begegnen und nachhaltig anpassbare Engineering-Kompetenzen aufbauen kann.

1 – Mechanische Analyse der drei technologischen Pfade: Das Dreiecks-Dilemma aus Last, Wärme und Raum

Die gestiegene Zellkapazität verändert direkt die Randbedingungen für das Pack-Systemdesign. Das Untergehäuse als „Skelett“ und „Haut“ des Systems muss drei Grundfragen neu beantworten:

a. Mechanische Analyse für 587Ah (Hochintegrationspfad)

Kernanforderung: Eine Energiedichte von ≥6 MWh in einem standard 20-Fuß-Container zu erreichen, treibt extrem kompakte Layouts wie „4 Spalten, 8 Cluster“ voran.

Herausforderungen für das Untergehäuse:

· Optimierung der Struktur-Tragfähigkeit: Bei erhöhter Gesamtmasse und reduzierten Stützpunkten muss das Gehäuse die Kraftübertragungspfade optimieren, um Gesamtsteifigkeit und lokale Festigkeit in kritischen Bereichen für Stabilität bei Transport und Betrieb zu gewährleisten.

· Integration der thermischen Managementstruktur: Das Flüssigkühlsystem ist tief mit dem Gehäuseboden und der Tragstruktur integriert – es dient sowohl als Kern des Wärmemanagements als auch als teilweise tragendes Element. Das Design muss dauerhafte Kühldichtigkeit unter langfristiger Strukturbelastung und thermischer Zyklisierung sicherstellen.

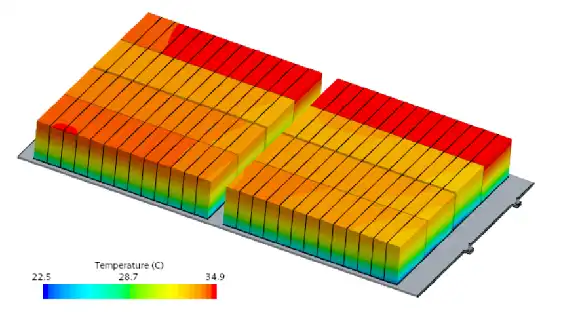

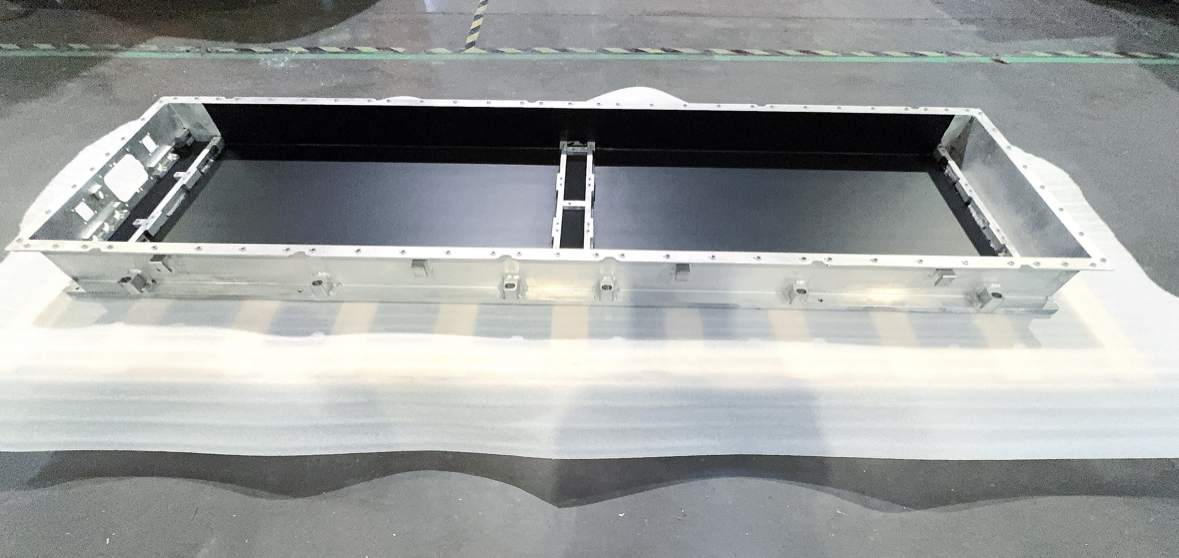

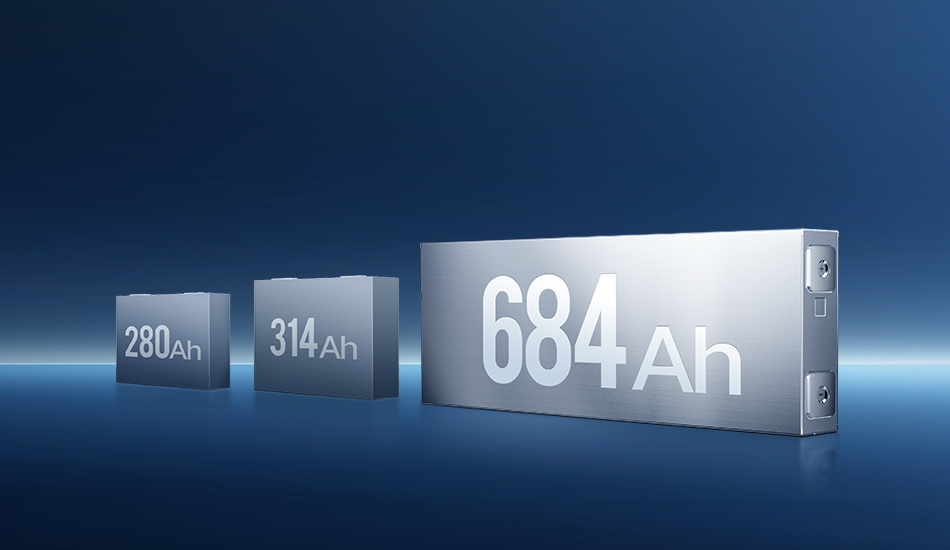

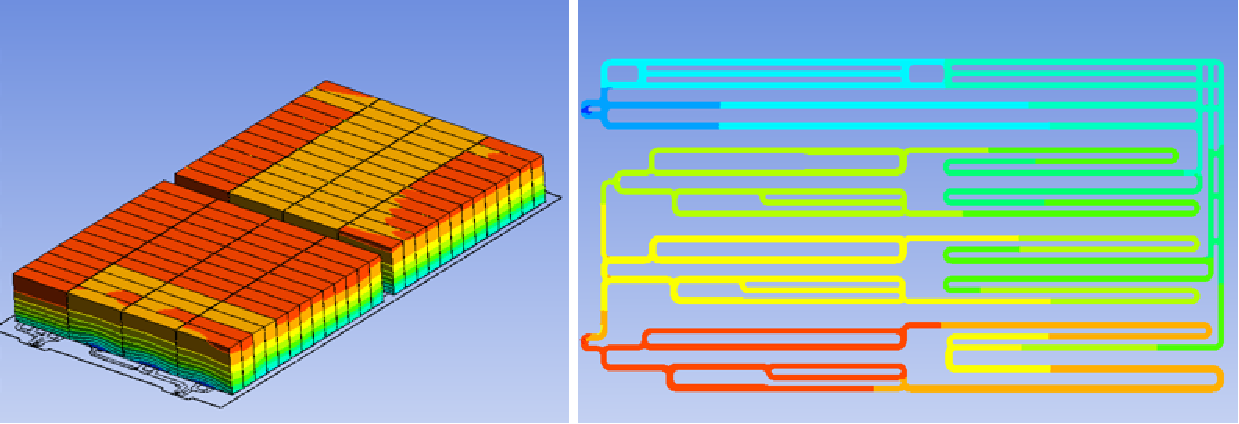

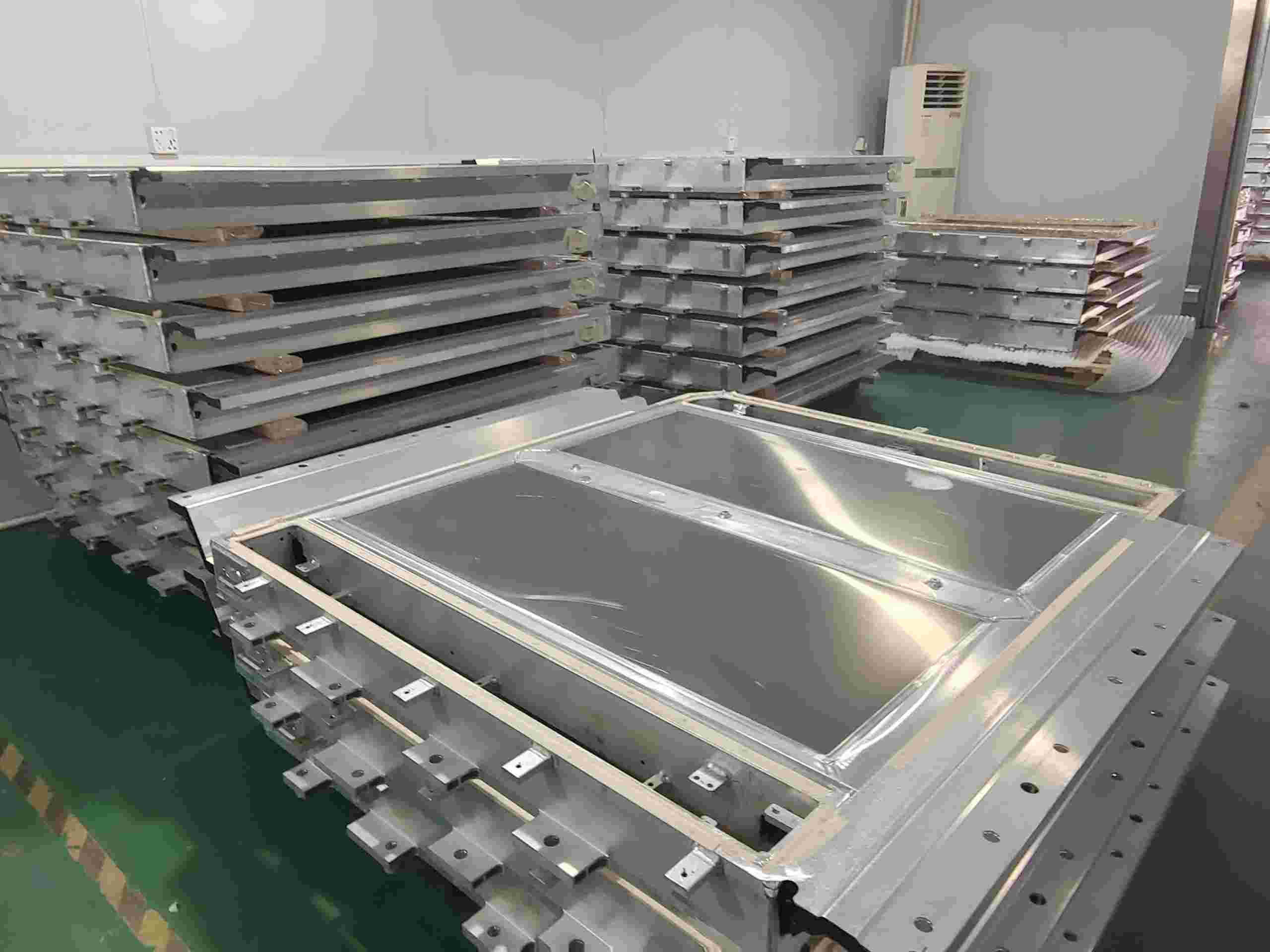

Abbildung 1: Simulation des Untergehäuses eines Energiespeicher-Packs

· Präzise Raumkoordination: Das Gehäuse muss in begrenztem Raum angemessene Toleranzen für Zellausdehnung, thermische Verschiebungen elektrischer Verbindungen und Feuerlöschleitungen vorsehen, um ein zuverlässiges Nebeneinander aller Subsysteme im kompakten Layout zu ermöglichen.

b. Thermo-mechanische Analyse des 684Ah-Pfads (Übergroße Kapazität)

Kernanforderung: Minimierung der Kosten pro Wh durch Maximierung der Einzelzellenkapazität, was jedoch physikalische Zentralisierungseffekte mit sich bringt.

Herausforderungen für das Untergehäuse:

· ‚Fokus‘-Effekt der Ausdehnungskräfte: Die Ausdehnungskraft einer einzelnen Zelle steigt nicht linear, sondern nahezu exponentiell mit der Kapazität. Der interne Rahmen des Gehäuses erfordert ein stärkeres und gleichmäßigeres ‚Bindungssystem‘, um die konzentrierten Ausdehnungsspannungen auf das gesamte Gehäuse zu verteilen und lokale plastische Verformungen zu vermeiden.

· ‚Gleichmäßigkeits‘-Dilemma im Wärmemanagement: Größere Wärmequellen benötigen effizientere Wärmeleitpfade. Das Material, die Dicke der Gehäusebodenplatte und das Design der Kontaktfläche zum Zellenboden (z.B. Kompressionsrate der Wärmeleitpads) werden entscheidend. Bei thermischem Durchgehen stellen die größere freigesetzte Energie höhere Anforderungen an die gerichtete Ableitfähigkeit der Druckentlastungskanäle und die Feuerwiderstandsdauer interner Brandschutztrennwände.

· Strukturelle Reaktion auf Gewichtskonzentration: Die schwereren Einzelzellen verändern die gesamten Vibrationsmodi des Packs. Das Untergehäuse erfordert neue Ermüdungssimulationen, um eine Lockerung von Verbindungselementen oder Strukturrissen durch Resonanz bei bestimmten Frequenzen zu verhindern.

c. Fertigungsanpassung für den 392Ah-Pfad (Robuster Übergangspfad)

Kernanforderung: Ausgewogenes Verhältnis von Leistung, Kosten und Liefereffizienz, um eine umfassend validierte Marktlösung bereitzustellen.

Herausforderungen für das Untergehäuse:

· Stabile Umsetzung einer ausgereiften Lösung: Basierend auf einem bewährten Design- und Fertigungssystem wird durch strenge Prozesskontrolle Produktkonsistenz sichergestellt, um einen schnellen und stabilen Massenproduktionsrhythmus zu unterstützen.

· Tiefgreifende Lieferketten-Synergie: Durch Nutzung etablierter Zuliefernetzwerke und mittels Materialauswahl, Prozessoptimierung und Massenbeschaffung wird die umfassende Kosteneffizienz des Produkts kontinuierlich gesteigert.

2 – Differenziertes Ingenieurdenken als Antwort:

Angesichts mehrerer Technologiepfade können Untergehäuse-Lieferanten nicht für jeden Weg ein neues technisches System aufbauen. Die eigentliche Lösung liegt in einer plattformbasierten, präzisen Reaktion – mit skalierbarem, modularisiertem Design, um verschiedene Anforderungen effizient anzupassen.

a. Fokus auf gemeinsame physikalische Prinzipien und Kooperationsmodelle

Die Zellenentwicklung folgt stabilen physikalischen Gesetzen. Wir haben einen gemeinsamen Bewertungsprozess auf Basis von Kernparametern etabliert. Unter Einbeziehung von Material- und Strukturdaten ermöglicht dies eine schnelle Einschätzung der Machbarkeit neuer Zellen, eine frühzeitige Identifizierung von Kompatibilitätsrisiken, eine Fokussierung der Designrichtung und eine Reduzierung späterer Nacharbeiten.

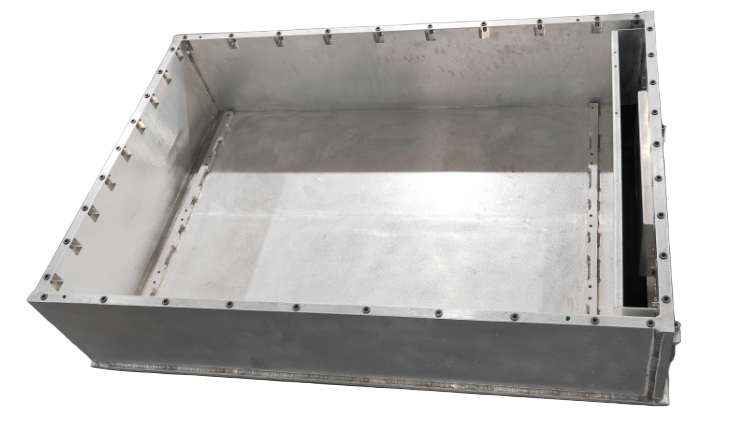

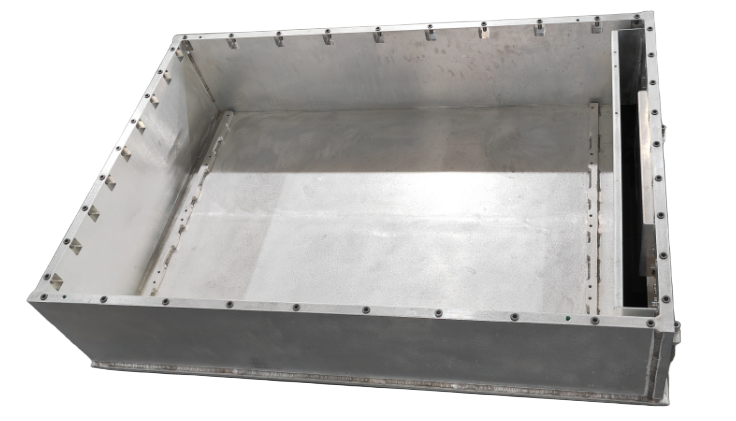

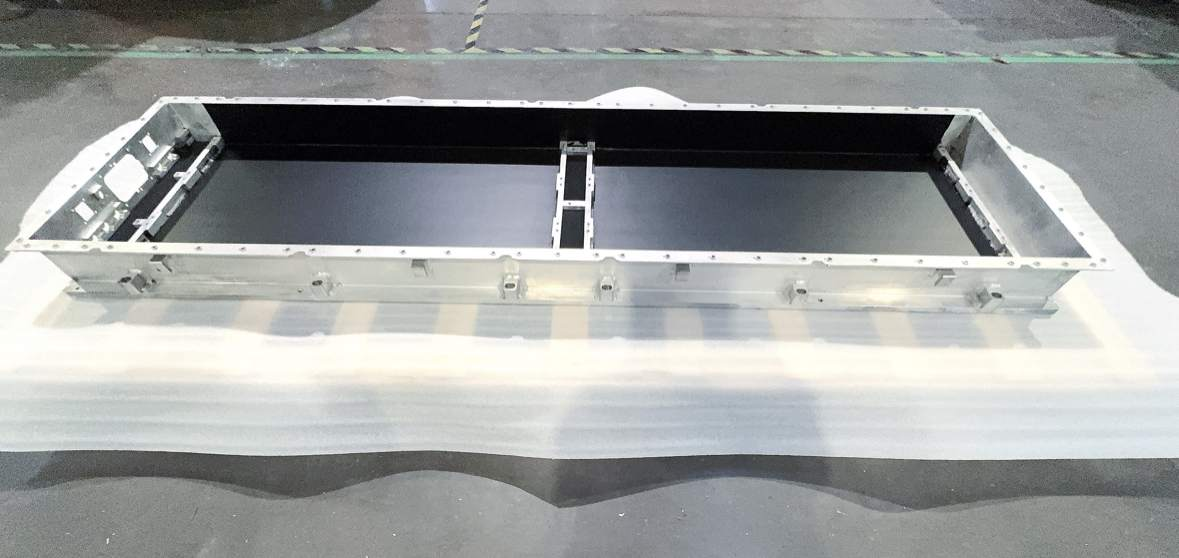

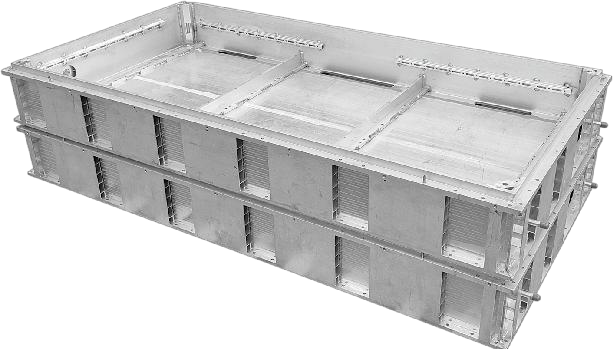

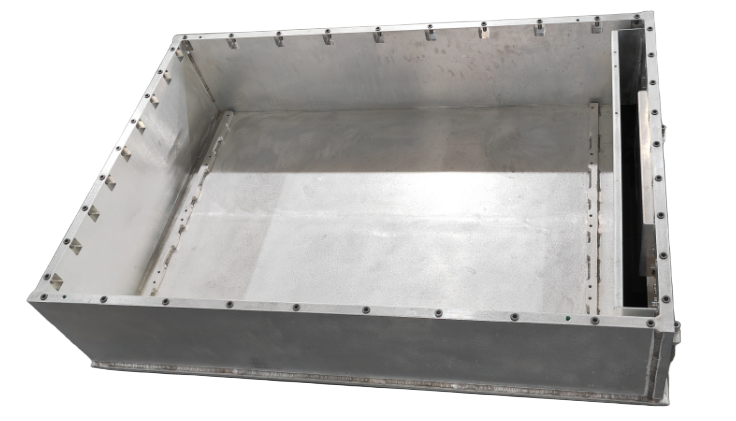

Abbildung 2: Untergehäuse für 587Ah-Energiespeicher-Pack

b. Aufbau eines flexiblen Systems aus „Standard-Schnittstellen + konfigurierbaren Modulen“

Um den kundenspezifischen Anforderungen durch divergierende Technologiepfade zu begegnen, haben wir ein klares Designsystem mit standardisierten Schnittstellen und intern konfigurierbaren Modulen etabliert:

· Einheitliche externe Schnittstellen: Montagepositionierung zum Energiespeicher-Container, elektrische Durchführungen, Anschlüsse für das Kühlsystem usw. halten sich strikt an gängige Branchenspezifikationen, um Kompatibilität und Montagekonsistenz auf Systemebene sicherzustellen.

· Konfigurierbare interne Struktur: Wir bieten eine Reihe interner Stützkomponenten und integrierter Wärmemanagement-Lösungen, die flexibel je nach Zellengröße und Anordnung kombiniert werden können.

· Integriertes Wärmemanagement-Modul: Das thermische Managementmodul ist modular aufgebaut. Kernziel ist die optimierte Temperaturregelung und Temperaturhomogenität der Zellen, wodurch es flexibel an die thermischen Anforderungen verschiedener Technologiepfade angepasst werden kann.

c. Einführung flexibler Fertigungslinien nach dem Prinzip „Fertigung als Teil des Designs“

Um der Vielfalt der Technologiepfade gerecht zu werden, ist unser Fertigungssystem um eine skalierbare Grundplattform und modulare Montage organisiert:

· Fertigung der Grundgehäuse-Plattform: Sie gewährleistet Präzision und Konsistenz der Hauptstruktur und bietet so eine zuverlässige Basis für verschiedene Konfigurationen.

· Modulare Montageeinheiten: Sie ermöglichen die flexible Auswahl und Montage entsprechender interner Stütz- und Wärmemanagementmodule basierend auf Zellengröße und Anordnung. Durch diesen Aufbau können wir auf derselben Produktionslinie effizient zwischen Produkten unterschiedlicher Technologiepfade wechseln und Kunden so bei der Bewältigung von Lieferketten- und Logistik-Herausforderungen unterstützen, die sich aus der parallelen Entwicklung mehrerer Pfade ergeben.

3 – Neudefinition des Werts des Untergehäuses: Vom passiven Träger zum aktiven Enabler

Das Untergehäuse entwickelt sich vom passiven Behälter zum systemkritischen Ermöglichungsbauteil, das Sicherheit, Energiedichte und Lebenszykluskosten direkt beeinflusst:

a. Sichere Tragstruktur: Durch Bereitstellung zuverlässiger struktureller Kanäle und Montagebasen für systemweite Druckentlastung und Brandschutztrennwände bildet es gemeinsam mit der Kontrolle der thermischen Ausbreitung einen mehrstufigen Sicherheitsschutz.

b. Unterstützung der Energiedichte: Leichtbau- und hochfeste Designs reduzieren Eigengewicht und Platzbedarf und schaffen so mehr Leistungsspielraum für Zellen und Kühlsystem.

c. Gewährleistung langfristiger Zuverlässigkeit: Strukturelle Integrität und Ermüdungsfestigkeitsauslegung befähigen das System, anhaltenden Herausforderungen wie Langzeitzyklen und Transportvibrationen standzuhalten.

4 – Fazit: Eine Brücke schlagen zwischen divergierender Upstream-Entwicklung und bestimmter Downstream-Anwendung

Mit der Weiterentwicklung der Zellentechnologie streben Energiespeichersysteme kontinuierlich nach mehr Sicherheit, höherer Dichte und geringeren Kosten. Das Untergehäuse muss eine zuverlässige und anpassungsfähige Basis bieten und durch Modularität sowie flexible Fertigung auf verschiedene Technologiepfade reagieren. Der Branchenwettbewerb verlagert sich zunehmend auf systemisches Engineering, wobei das Pack-Gehäuse ein Schlüsselelement darstellt.

Wir werden regelmäßig Informationen und Technologien zu Wärmedesign und Leichtbau aktualisieren und mit Ihnen teilen. Vielen Dank für Ihr Interesse an Walmate.

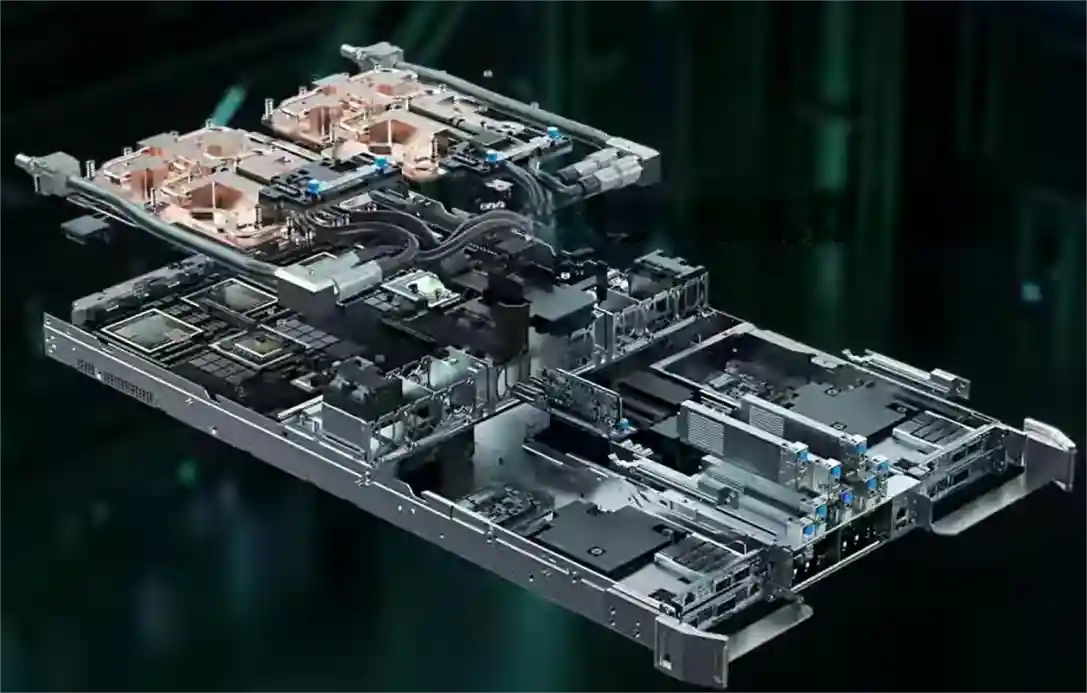

Während der jahrzehntelangen Entwicklung von Rechenzentren blieb Luftkühlung die vorherrschende Wahl. Mit der Einführung der NVIDIA GB200-Serie wird dieses Gleichgewicht jedoch grundlegend durchbrochen. Wenn die Rechendichte neue Höhen erreicht, können traditionelle Kühlmethoden den Anforderungen nicht mehr gerecht werden. Flüssigkühlung rückt endgültig aus dem Hintergrund in den Vordergrund und wird zur entscheidenden Infrastruktur für KI-Rechenleistung.

1 – Grundlegender Wandel auf der Nachfrageseite

a. Leistungsdichte durchbricht kritische Schwelle

Die Leistungsdichte des GB200 NVL72-Racks wird voraussichtlich über 30 kW pro Rack liegen – ein Wert, der die Kühllimit von traditioneller Luftkühlung (15–20 kW) weit übersteigt. Dies bedeutet:

· Zwangsläufige Technologiewahl: Flüssigkühlung wird von „überlegenswert“ zur „einzigen Option“.

· Qualitativer Wandel des Marktvolumens: Jede GB200-Installation bedeutet einen gesicherten Bedarf an Flüssigkühlung.

· Deutliche Werterhöhung: Der Wert des Flüssigkühlsystems pro einzelnes Rack erreicht eine Größenordnung von mehreren hunderttausend RMB.

b. Anforderungen an die Zuverlässigkeit steigen

Mit steigender Rechendichte pro Rack wächst auch der geschäftliche Wert, den es trägt, exponentiell. Die Zuverlässigkeit des Flüssigkühlsystems betrifft direkt:

· Geschäftskontinuität: Ein einziger Kühlungsausfall kann Rechenleistungsverluste in Millionenhöhe verursachen.

· Systemlebensdauer: Pro 10 °C Temperaturerhöhung halbiert sich die Lebensdauer elektronischer Komponenten.

· Leistungsstabilität: Die Kühleffizienz bestimmt direkt, ob Chips dauerhaft ihre Spitzenleistung halten können.

2 – Umfassend gesteigerte technische Anforderungen

a. Sprungartig erhöhte Anforderungen an die Kühlleistung

Der GB200 stellt bisher unerreichte Anforderungen an das Kühlsystem:

· Verdopplung der Wärmeleitfähigkeit

· Die Wärmeleitfähigkeit der Kühlplatte muss das 3- bis 5-fache herkömmlicher Lösungen erreichen

· Der Kontaktwiderstand muss um eine Größenordnung reduziert werden

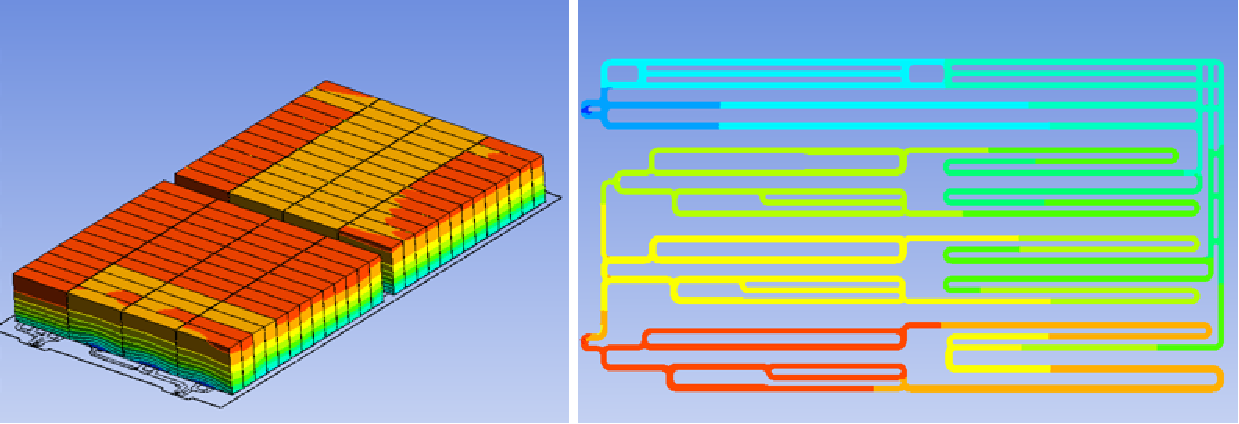

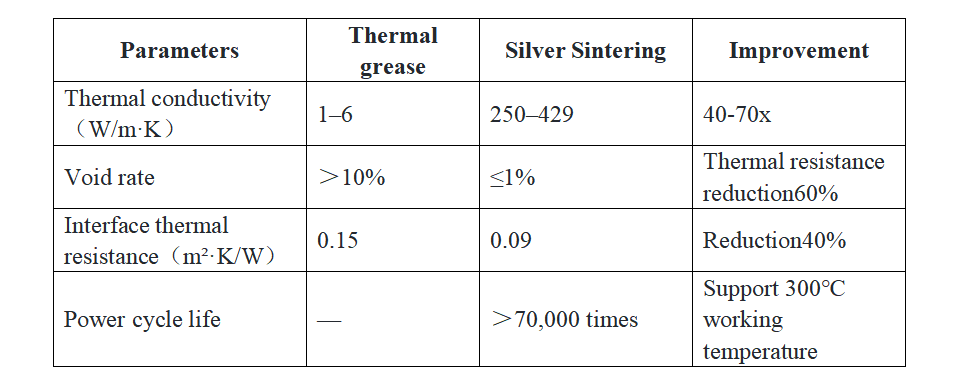

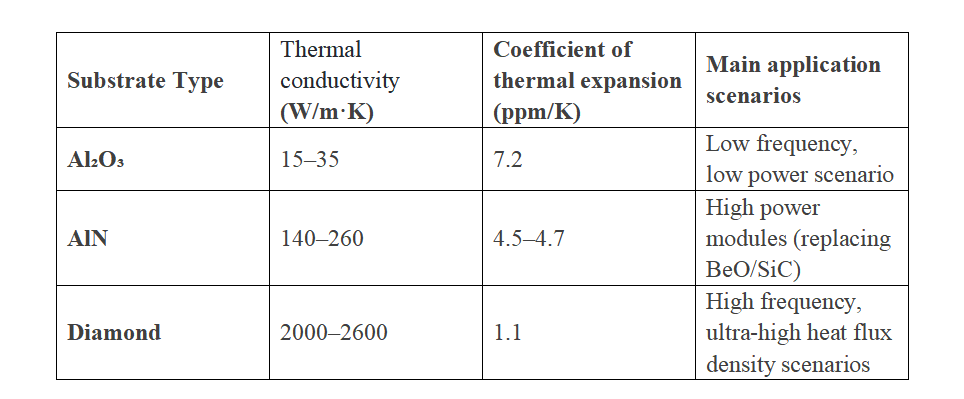

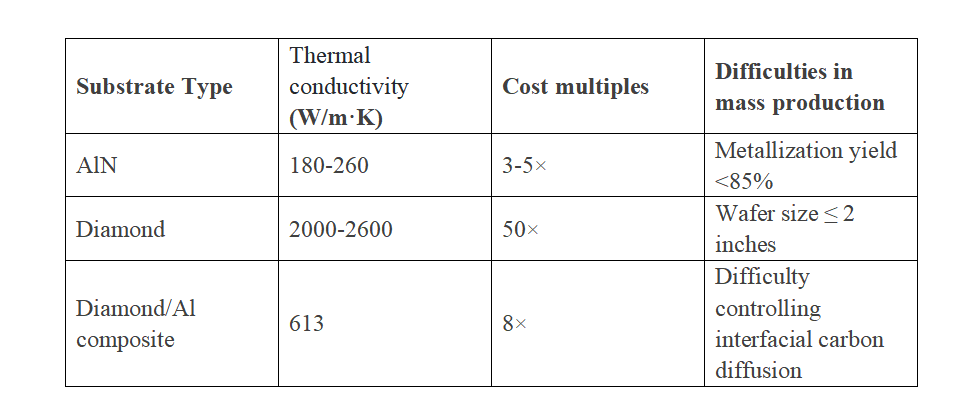

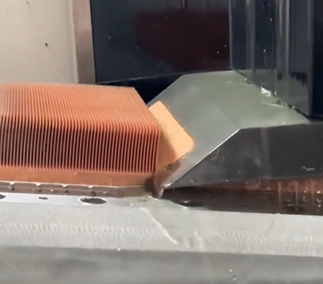

Abbildung 1 – Mikrokanal-Flüssigkühlplatte

b. Präzise Durchflusskontrolle

· Eine Durchflussregelgenauigkeit von innerhalb ±1 % muss erreicht werden

· Unterstützung dynamischer Durchflussanpassung für verschiedene Lastprofile

c. Temperaturhomogenität

· Die Temperaturdifferenz auf der Chip-Oberfläche muss innerhalb von 5 °C kontrolliert werden

· Lokale Hotspots müssen vermieden werden, um die Systemstabilität zu gewährleisten

3 – Sprunghaft gestiegene Systemintegrationskomplexität

Flüssigkühlsysteme haben sich von einfachen Komponentenlieferungen zu komplexen Systemprojekten entwickelt:

a. Traditionelles Modell:

· Bereitstellung standardisierter Kühlplatten

· Einfache Rohrverbindungen

· Grundlegende Überwachungsfunktionen

b. GB200-Ära:

· Rack-weites Flüssigkühl-Architekturdesign

· Intelligentes Durchflussverteilungssystem

· Echtzeit-Überwachung des Systemzustands

· Fähigkeit zur vorausschauenden Wartung

Abbildung 2 – NVIDIA GB200-Rack

4 – Umfassend gesteigerte Wettbewerbsbarrieren

In der neuen Marktumgebung müssen Unternehmen höhere Hürden überwinden:

a. Technologische Barrieren

Flüssigkühlungsunternehmen müssen die Grenzen einzelner Disziplinen durchbrechen und ein interdisziplinäres Technologieportfolio aufbauen. Die tiefe Integration multidisziplinärer Technologien – wie Mikrokanal-Design, Materialwissenschaften und Strömungsmechanik – ist zur Grundvoraussetzung geworden. Die Fähigkeit zur chipgenauen thermischen Simulation und Optimierung prüft zudem die technologische Tiefe eines Unternehmens. Es handelt sich nicht mehr um einfache Verfahrensverbesserungen, sondern um systemische Projekte, die langfristige F&E-Investitionen erfordern.

b. Zertifizierungsbarrieren

Das industrielle Zertifizierungssystem wird immer strenger. Unternehmen müssen nicht nur strenge Zuverlässigkeitstests der Server-Hersteller bestehen, sondern auch die technische Zertifizierung des Chip-Herstellers (OEM) erhalten. Diese doppelte Zertifizierung validiert nicht nur die technische Leistung des Produkts, sondern prüft auch das Qualitätsmanagement und die Fähigkeit zur kontinuierlichen, stabilen Lieferung. Sie ist zum erforderlichen Passierschein für den Eintritt in die kritische Lieferkette geworden.

c. Servicebarrieren

Da Flüssigkühlsysteme zum Kernsubsystem aufgestiegen sind, ist die Servicefähigkeit zu einem entscheidenden Wettbewerbsfaktor geworden. Unternehmen müssen ein landesweites Schnellreaktionsnetzwerk aufbauen und ein professionelles 24/7-Betriebs- und Wartungssystem etablieren. Diese Servicefähigkeit erfordert nicht nur rechtzeitigen technischen Support, sondern vor allem vorbeugende Wartung und Notfallbehandlung in Form einer kompletten Service-Lösung – um so zum wirklich vertrauenswürdigen Partner der Kunden zu werden.

Wir werden regelmäßig Informationen und Technologien zu Wärmedesign und Leichtbau aktualisieren und mit Ihnen teilen. Vielen Dank für Ihr Interesse an Walmate.

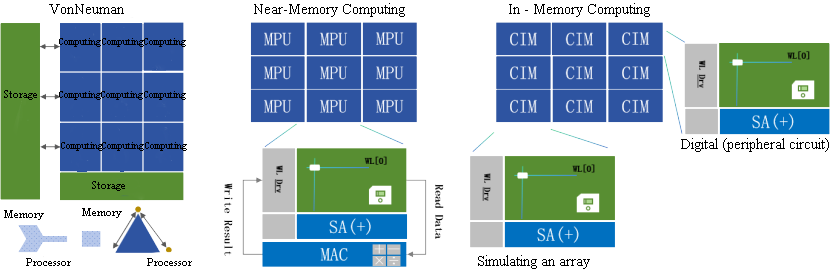

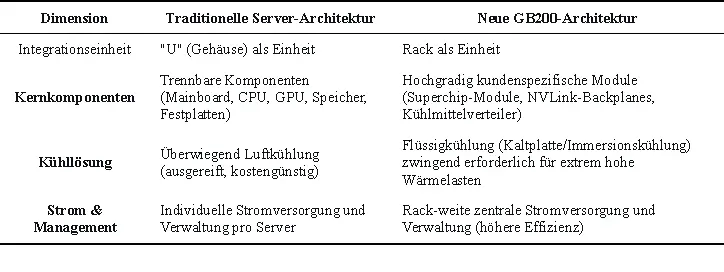

In der Entwicklungsgeschichte der Rechenarchitektur kommen einige Momente nicht leise. Die Vorstellung des NVIDIA GB200 NVL72 ist ein solcher Moment – nicht nur ein neues Produkt, sondern eine vollständige Neudefinition des Server-Begriffs.

Dreißig Jahre lang bedeutete "Server" eine standardisierte Gehäuseeinheit: mit Hauptplatine, CPU, Speicher, Festplatten und Erweiterungskarten, verbunden über Industrieschnittstellen. Gemessen in "U", gestapelt in Racks, vernetzt über Kabel. Doch der GB200 NVL72 zersetzt diese Definition im Kern.

Sein Wesen ist nicht länger "ein Server", sondern ein "Rechensystem" in Rack-Form. Traditionelle Komponenten werden dekonstruiert und durch NVLink-C2C, Flüssigkühlung und Rack-Strommanagement in eine untrennbare Einheit reintegriert. Dies ist kein Upgrade, sondern ein Paradigmenwechsel.

1 - Was ist ein "Server"? Die Antwort wandelt sich

Dreißig Jahre lang war ein Server ein standardisiertes Gehäuse: Hauptplatine, CPU, Speicher, Festplatten, Erweiterungskarten – alle nach Industriestandards austauschbar.

Doch GB200 ändert dies fundamental:

· Rechenkern nicht mehr separate CPU/GPU, sondern GB200 Superchip – eine integrierte CPU-GPU-Einheit

· Verbindung nicht über PCIe, sondern über Anpassung NVLink-Backplanes

· Kühlung nicht optional, sondern integriertes Flüssigkühlsystem

· Bereitstellungseinheit wechselt vom "Gehäuse" zum "Rack"

Traditionelle Serverkomponenten werden "zerlegt" und auf Rack-Ebene neu integriert. Keine Evolution, sondern Rekonstruktion.

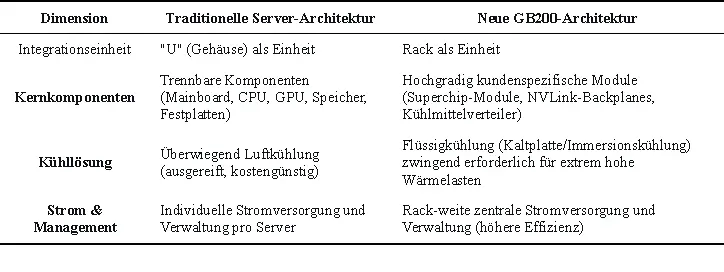

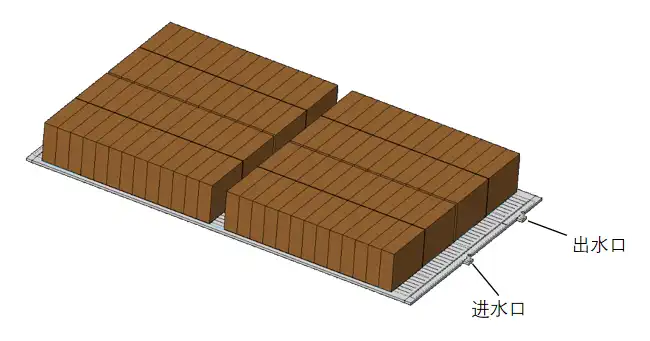

Tabelle 1 - Neudefinition der physischen Architektur: Vom "Gehäuse" zum "Rack"

2 - Die drei Säulen der „Rack-Level-Architektur“

Das traditionelle Serverdesign balanciert und kompromittiert innerhalb eines geschlossenen Gehäuses. Die durch den GB200 repräsentierte Rack-Level-Architektur hingegen betrachtet Kühlung, Konnektivität und Stromversorgung in einer neuen Dimension als komplettes System im Top-Level-Design. Es geht nicht mehr um das Stapeln von Komponenten, sondern um eine systemweite Tiefenintegration. Dies basiert auf der synergetischen Innovation von drei Kernpfeilern.

Säule 1: Vom „Networking“ zum „Backplane-Bus“

In traditionellen Rechenzentren sind Server eigenständige Knoten, die über Netzwerke (wie Ethernet) kommunizieren. Im GB200 NVL72 hat der NVLink-Fabric im Rack die Rolle des Busses auf einem Mainboard übernommen und wird zum „Rückgrat“, das alle Recheneinheiten verbindet. Dies ermöglicht, dass 72 GPUs im Rack wie eine einzige riesige GPU zusammenarbeiten, mit optimierter Kommunikationsbandbreite und Latenz um Größenordnungen.

Säule 2: Kühlung wird vom „Support-System“ zum „Kern-Subsystem“

Wenn die Rechendichte von einigen Dutzend Kilowatt auf über hundert Kilowatt pro Rack steigt, stößt traditionelle Luftkühlung an ihre Grenzen. Flüssigkühlung ist kein optionales „Support-System“ mehr, sondern ein Kernsubsystem, gleichwertig mit Rechenleistung und Konnektivität. Ihr Design entscheidet direkt über die Performance und Stabilität des Gesamtsystems und ist der Schlüssel von „funktionsfähig“ zu „hochleistungsfähig“.

Säule 3: „Zentralisierung und Restrukturierung“ von Management und Stromversorgung

Der GB200 nutzt eine rackweite zentrale Stromversorgung und Verwaltung. Dies zielt nicht nur auf eine höhere Stromwandlungseffizienz ab, sondern definiert auch die Systemkopplung neu. Es führt zu vereinfachter Verkabelung und einer einheitlichen Managementansicht, erweitert jedoch auch die Fehlerdomäne von einem einzelnen Server auf das gesamte Rack und stellt neue Anforderungen an den Betrieb.

3 - Neustrukturierung und Verlagerung der Wertschöpfungskette

Die „Rack-Level-Architektur“, verkörpert durch den GB200, wirkt weit über die Technologie selbst hinaus und zeichnet klar den Verlauf einer neuen branchenweiten Wertschöpfungskette nach. Traditionelle Wertverteilungen werden aufgebrochen, neue Wertschöpfungszentren entstehen bei der systemweiten Integration und der Software-Hardware-Synergie.

Server-Hersteller: Strategischer Wandel vom ‚Definierer‘ zum ‚Integrator‘

Traditionelle Server-Giganten wie Dell und HPE sehen ihre Kernwerte schwinden. Deren einstige Überlebensgrundlage – Mainboard-Design, Systemoptimierung und Standardfertigung – verliert in hochgradig kundenspezifischen,Werkseitig integriert Systemen wie dem GB200 an Bedeutung.

Doch in der Krise liegen neue strategische Chancen:

· Wertverlagerung nach oben: Der Wettbewerbsfokus verschiebt sich vom Server-Innendesign zu Rack-Level-Flüssigkühlung, Stromversorgungseffizienz und Strukturlayout.

· Wertausweitung: Die Kernkompetenz erweitert sich von der Hardware-Fertigung hin zu professionellen Services für Massenbereitstellung, plattformübergreifendes Betriebsmanagement und Integration in bestehende IT-Landschaften.

Dies bedeutet eine Transformation der Rolle: Vom „Definierer“ standardisierter Produkte zum „höherwertigen Integrator und Enabler“ komplexer Systeme.

‚Strategischer Einkauf‘ der Cloud-Anbieter: Balance zwischen Abhängigkeit und Autonomie

Für Hyperscaler ist der GB200 sowohl strategische Notwendigkeit als auch Warnung.

· Kurzfristige Taktik: Als ultimative Rechenleistungs-Referenz ist der GB200-Einkauf eine zwingende Wahl, um die Marktnachfrage nach top KI-Leistung zu bedienen.

· Langfristige Strategie: Um Lieferkettenrisiken und Vendor-Lock-in zu vermeiden, sind eigenentwickelte KI-Chips (wie TPU, Trainium, Inferentia) zur Kernstrategie für künftige Autonomie geworden.

Ihr Verhalten spiegelt die komplexe Abwägung zwischen Effizienz und Autonomie, kurzfristigem Markt und langfristiger Kontrolle wider.

Entwicklung der Entscheidungsfindung bei Endkunden: Von der Bewertung der ‚Komponenten‘ zur Bewertung des ‚Outputs‘

Für technische Entscheidungsträger (CTOs, technische VPs) vollzieht sich ein fundamentaler Wandel im Beschaffungsparadigma.

Traditionelle Einkaufsliste:

· CPU-Kerne und Taktfrequenz

· GPU-Modell und -Anzahl

· Speicher- und Storage-Kapazität sowie -Geschwindigkeit

Heutige strategische Überlegungen:

· Effizienzkennzahlen: Leistung pro Watt, gesamte Modelltrainingszeit

· Gesamtbetriebskosten (TCO): Umfassende Kosten inkl. Hardware, Energie, Betrieb und Personal

· Geschäftsagilität: Zeitzyklus von der Bereitstellung bis zum Ergebnis

Dieser Wandel markiert den entscheidenden Übergang der Technologiebeschaffung von einer Cost-Center- zu einer Produktivitäts-Investitions-Mentalität.

Der GB200 definiert die Recheneinheit neu – vom „Server“ zum „Rack“. Dies ist mehr als ein Leistungsupgrade, es ist ein vollständiger Architekturparadigmenwechsel. Das Streben nach Effizienz übertrifft das reine Komponentenstapeln, die Wertschöpfungskette der Branche wird neu strukturiert. In diesem Wandel ist nur eines sicher: Sich anpassen oder zurückbleiben.

Eine neue Ära des Rechnens hat begonnen.

Wir werden regelmäßig Informationen und Technologien zu Wärmedesign und Leichtbau aktualisieren und mit Ihnen teilen. Vielen Dank für Ihr Interesse an Walmate.

Wenn Ihre Geräte mehrere Kernwärmequellen mit unabhängigen Betriebszuständen, unterschiedlichen Verlustleistungen oder Isolationskühlanforderungen aufweisen, stößt eine traditionelle Einzelkanal-Kühlplatte an ihre Grenzen – mehrkreisige Flüssigkühlkörper mit eingebetteten Kupferrohren sind hier die entscheidende Lösung.

1-Warum Mehrkreislauf? Drei Hauptanwendungsfälle adressieren konkrete Probleme

a. Thermische Entkopplung für die Leistungssicherung kritischer Komponenten

Wenn verschiedene Bauteile wie IGBTs und Dioden oder CPUs und GPUs eng beieinander angeordnet sind, kann ein einzelner Kühlkanal zu gegenseitiger Wärmeinterferenz ("Übersprechen") führen. Dies zwingt weniger wärmeerzeugende Komponenten, bei höheren Temperaturen zu arbeiten. Ein Mehrkreislauf-Design wirkt wie eine "individuelle Klimaanlage" für jedes Bauteil, unterbindet Wärmeinterferenz wirksam und gewährleistet, dass jede Einheit in ihrem optimalen Temperaturbereich arbeitet – was die Systemleistung und Stabilität steigert.

b. Systemredundanz für hochzuverlässige Architekturen

In Bereichen mit extrem hohen Zuverlässigkeitsanforderungen (z.B. Server, Kommunikations-Basisstationen) führt ein Ausfall eines einzelnen Kühlkreislaufs zum Systemstillstand. Das Mehrkreislauf-Design ermöglicht ein "N+1"-Redundanz-Kühlsystem. Bei einem unerwarteten Ausfall eines Kreislaufs können die verbleibenden Kreisläufe weiterhin eine Grundkühlung bereitstellen. Dies verschafft wertvolle Zeit für Wartungsarbeiten und ist grundlegend für hochverfügbare Designs.

c. Anpassung an unregelmäßige Layouts und differenzierte Kühlanforderungen

Bei ungleichmäßig verteilten Wärmequellen ist eine homogene Kühlung mit einem einzigen Kanal schwer zu erreichen. Mehrkreisläufe ermöglichen eine "maßgeschneiderte" Lösung: Sie können den Verlauf jedes Kupferrohrs flexibel an die tatsächliche Form und Anordnung der Wärmequellen anpassen, um jede Wärmequelle präzise mit dem optimalen Kanalweg zu versorgen. Gleichzeitig können Sie leistungsstarke Kreisläufe für Bauteile mit hoher Verlustleistung und kleinere Kreisläufe für solche mit geringerer Leistung konfigurieren – für eine optimale Zuordnung der Kühlressourcen.

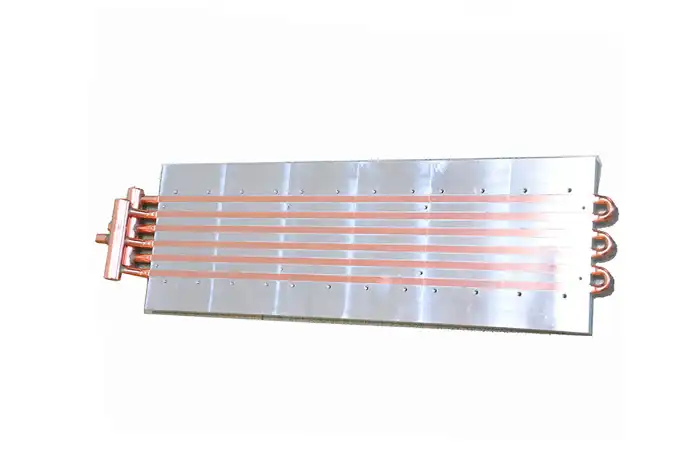

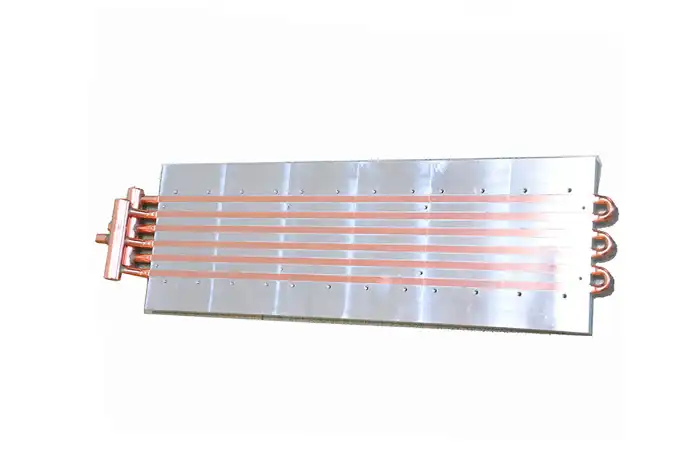

Abbildung 1: Mehrkreis-Flüssigkühlplatte mit eingebettetem Kupferrohr

2-Design- und Fertigungskern: Wie lassen sich Leistung und Zuverlässigkeit auf engstem Raum in Einklang bringen?

Beim Mehrkreislauf-Design ist der Kanalabstand der entscheidende Erfolgsfaktor.

a. Thermische Mindestanforderung: Vermeidung von "thermischen Kurzschlüssen"

Ist der Abstand zwischen benachbarten Kanälen zu gering, kann sich Wärme selbst bei unabhängigen Kreisläufen schnell durch das dazwischenliegende Aluminiumsubstrat ausbreiten – die Isolationswirkung wird erheblich beeinträchtigt. Durch Simulationen und Tests haben wir einen Mindestabstand vom ≥1,5-fachen Rohrdurchmesser als Grundprinzip festgelegt, um die thermische Unabhängigkeit sicherzustellen.

b. Strukturelle Grenze: Wahrung der "drucktragenden Lebenslinie"

Das Aluminiumsubstrat zwischen den Kanälen stellt eine Schwachstelle für die Innendruckbelastung dar. Ein zu enger Abstand führt zu unzureichender Stegfestigkeit, was bei Druckspitzen ein Aufreißrisiko birgt. Mithilfe mechanischer Spannungssimulationen stellen wir sicher, dass die Spannung zwischen den Kanälen unter allen Betriebsbedingungen deutlich unter der Streckgrenze des Materials bleibt – und eliminieren so grundsätzlich die Gefahr des "Berstens der Platte".

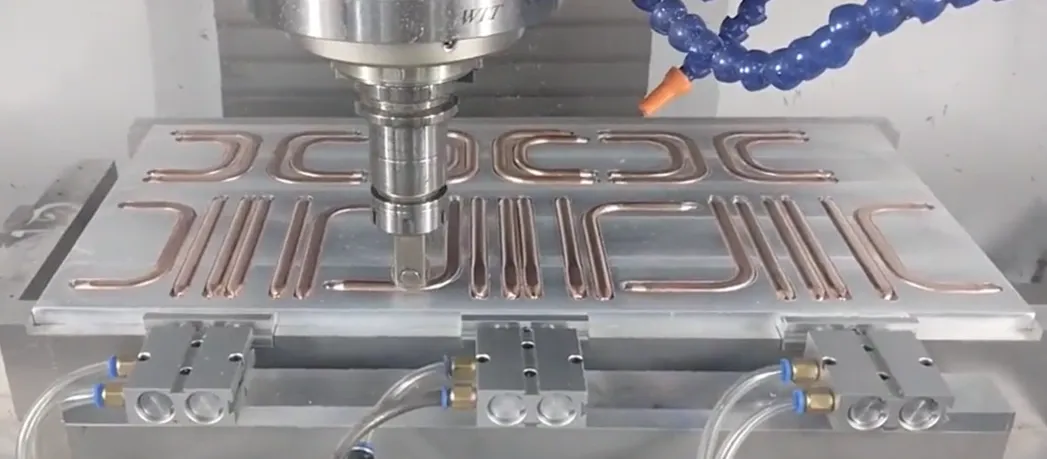

Abbildung 2: Flüssigkühlplatte mit eingebettetem Kupferrohr

c. Fertigungstechnische Limiten: Sicherstellung der "Präzisionsfertigung"

Enge Abstände stellen hohe Anforderungen an die Fräswerkzeuge für die Nutbearbeitung. Basierend auf umfassender Fertigungserfahrung setzen wir den Abstand in Relation zum Werkzeugdurchmesser. So gewährleisten wir nicht nur eine effiziente Bearbeitung, sondern auch glatte und ebene Nutwände – die Grundvoraussetzung für den späteren formschlüssigen Einbau der Kupferrohre und eine wärmeleitoptimierte Verbindung.

3- Wichtige Aspekte der technischen Umsetzung

Eine erfolgreiche Mehrkreislauf-Konstruktion erfordert die Beachtung folgender Punkte:

a. Kooperatives Design

Es wird empfohlen, thermisches und mechanisches Design bereits in der Konzeptphase zu integrieren. Strömungskanallayout, strukturelle Festigkeit und Fertigungsmöglichkeiten sollten gemeinsam betrachtet werden, um nachträgliche Designänderungen zu vermeiden.

b.Prozesskontrolle

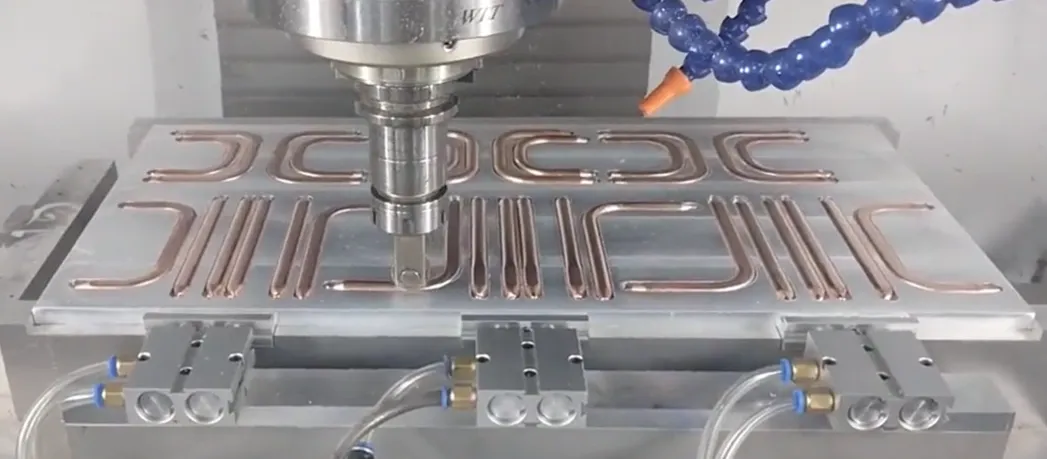

• Hochpräzises CNC-Nutenfräsen zur Sicherstellung der Nutenbreitentoleranzen und Oberflächenqualität

• Anwendung der Innendorn-Biegetechnik für Kupferrohre, um deren Durchgängigkeit und gleichmäßige Wandstärke nach dem Biegen zu gewährleisten

• Zuverlässige Einlege- und Fixiertechnik zur Verhinderung von Rohrverschiebungen unter Vibrationsbedingungen

c.Verifikationstests:

• 100 %-Dichtheitsprüfung

• Charakterisierung der Durchfluss-Druckverlust-Charakteristik

• Verifikation des Wärmewiderstands

• Berstdrucktests

Zusammenfassend lässt sich sagen: Mehrkreisige Flüssigkühlkörper mit eingebetteten Kupferrohren sind eine wirksame Lösung für komplexe Kühlaufgaben mit mehreren Wärmequellen. Der Schlüssel zum Erfolg liegt im tiefen Verständnis ihrer Konstruktionslogik und im Finden des optimalen Gleichgewichts zwischen Leistung und Zuverlässigkeit.

Wir werden regelmäßig Informationen und Technologien zu Wärmedesign und Leichtbau aktualisieren und mit Ihnen teilen. Vielen Dank für Ihr Interesse an Walmate.

1-Vorverarbeitung von Kupferrohren (Biegen und Abflachen)

Ziel: Gerade, runde Kupferrohre so umformen, dass sie exakt der flachen Form des vorgesehenen Kanalprofils entsprechen.

a. Materialauswahl: Warum sauerstofffreies Kupfer?

Sauerstofffreies Kupfer (C1220) mit einer Reinheit von 99.9% und ohne Oxidide an den Korngrenzen ist äußerst duktil. Dies ermöglicht eine verformungsintensive Bearbeitung ähnlich wie bei Teig, wodurch beim Biegen und Abflachen Risse oder Mikrorisse vermieden werden, was die spätere Zuverlässigkeit gewährleistet.

b. Biegeradius: Die kritische Untergrenze

Der minimale Biegeradius muss ≥ dem 1.5-fachen des Rohrdurchmessers betragen – dies ist eine feste Regel. Bei Unterschreitung wird die Außenwand des Rohrs übermäßig gedehnt, dünner und kann reißen. Der Einsatz eines Innenabstütz-Biegegeräts (Dornbiegemaschine) ist entscheidend, um Faltenbildung auf der Rohrinnenseite zu verhindern.

c. Abflachen: Die präzise "Gewichtsreduktion"

Abflachen ist kein einfaches Zusammendrücken, sondern eine kontrollierte plastische Verformung mittels Präzisionswerkzeugen. Die Kanaltiefe nach dem Abflachen darf nicht weniger als 30% des ursprünglichen Innendurchmessers betragen. Das Kernziel ist eine gleichmäßige Wandstärke nach dem Abflachen. Lokale Totfalten oder übermäßiges Ausdünnen müssen unbedingt vermieden werden, da diese Stellen potenzielle spätere Leckagen darstellen.

Abbildung 1: Wärmerohr-Biegen

d. Verfahrensablauf: Erst biegen oder erst abflachen?

Zwingend „erst biegen, dann abflachen“. Das Biegen runder Rohre ist ein ausgereiftes und kontrollierbares Verfahren. Würde man zuerst abflachen, wäre das Biegen von abgeflachten Rohren mit kleinem Radius nahezu unmöglich und zudem qualitativ minderwertig; die Innenwände des Kanals würden sich stark verformen und einen drastischen Anstieg des Strömungswiderstands verursachen.

2- Grundplattenbearbeitung (Präzisionsfräsen von Nuten)

Ziel: Das Fräsen von maßgenauen "Schienen" in eine Aluminium-Grundplatte, in die die Kupferrohre eingelegt werden.

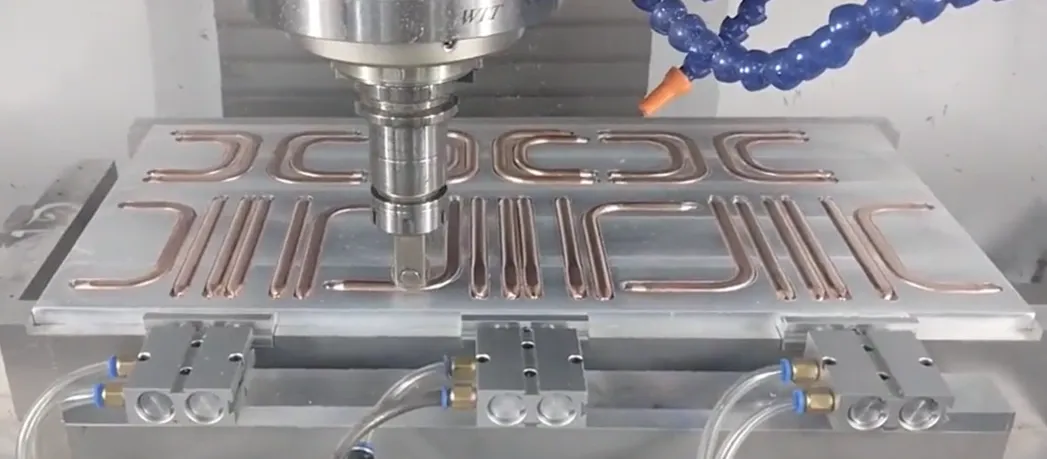

Abbildung 2: Eingebettetes Kupferrohr

a. Nutbreiten-Design: Übermaßpassung

Die Nutbreite muss geringfügig kleiner sein als die Breite des abgeflachten Kupferrohrs (typischerweise 0,05-0,1 mm weniger), um eine Übermaßpassung zu bilden. Diese erzeugt Reibungskräfte, die das Kupferrohr fest "umgreifen" und die Grundlage für die primäre Fixierung und die Verringerung des Kontaktwärmewiderstands bilden.

b. NuttiEFensteuerung: Bearbeitungszugabe für das Planfräsen

Die NuttiEFe bestimmt, wie weit das Kupferrohr nach dem Einlegen über die Grundplattenoberfläche hinausragt. Diese Höhe stellt die Bearbeitungszugabe für den nachfolgenden Planfräsprozess dar. Die Gleichmäßigkeit der NuttiEFe beeinflusst direkt die Endgleichmäßigkeit der verbleibenden Wandstärke des Kupferrohrs.

c. Werkzeug und "Schwingungen"

Beim Fräsen schmaler und tiefer Nuten kann es bei einem zu großen Länge-Durchmesser-Verhältnis des Fräsers zu "Schwingungen" (Chattern) kommen, was zu rauen Nutwänden und Maßabweichungen führt. Daher darf der Kanalabstand nicht zu gering sein; es muss ausreichend Raum für die Werkzeugstärke und -steifigkeit vorhanden sein.

d. Sauberkeit: Die unsichtbare Qualität

Nach dem Fräsen müssen Aluminiumspäne und Ölrückstände zu 100% entfernt werden. Jegliche Verunreinigungen bilden eine wärmedämmende Schicht zwischen Kupferrohr und Aluminiumgrundplatte, die den Kontaktwärmewiderstand erheblich erhöht und die Kühlleistung drastisch verschlechtert.

3-Einlegen und Fixieren

Ziel: Die geformten Kupferrohre präzise in die Nuten der Grundplatte einlegen und eine stabile Verbindung schaffen.

a. Übermaßpassung: Die primäre Haltekraft

Durch präzise Maßtoleranz wird das Kupferrohr unter Krafteinwirkung (z.B. Presse) in die etwas schmalere Nut „gepresst“. Die elastische Rückstellkraft der Materialien erzeugt einen erheblichen Flächendruck, welcher die primäre Quelle der Haltekraft darstellt.

Abbildung 3: Wärmerohr-Befestigung

b. Zusätzliche Fixierung: Verhindern von "Wippen"

Allein durch die Übermaßpassung könnten sich die Enden der Kupferrohre unter thermischer Belastung lösen und "wippen". Eine zusätzliche Fixierung ist erforderlich: Mikropunktschweißen (hohe Festigkeit, benötigt präzise Wärmesteuerung) oder wärmeleitendes Epoxidharz (geringere Spannungen, Alterungsrisiko).

c. Der Feind des Kontaktwärmewiderstands

Luft zwischen Kupferrohr und Aluminiumnut ist ein schlechter Wärmeleiter und die Hauptursache für den Kontaktwärmewiderstand. Hochwärmeleitfähige Klebstoffe oder das Verschweißen füllen mikroskopische Hohlräume, verdrängen die Luft und reduzieren den Wärmewiderstand erheblich.

d. Warnung vor galvanischer Korrosion

Aluminium und Kupfer bilden in Gegenwart eines Elektrolyten ein galvanisches Element, wobei Aluminium als Anode korrodiert. Daher müssen die Dichtheit des Kühlsystems gewährleistet und demineralisiertes Wasser bzw. korrosionsgehemmtes Kühlmittel verwendet werden, um den Korrosionspfad auf Systemebene zu unterbrechen.

4-Oberflächenbearbeitung (Planfräsen vs. Tiefeinbetten)

Ziel: Schaffung einer finalen Wärmeübertragungsfläche mit hoher Ebenheit und niedrigem Wärmewiderstand, die für die Montage von Chips geeignet ist.

a. Planfräsprozess: Die leistungsstärkste Methode

Verwendung von ultra-harten Werkzeugen zum gleichzeitigen Fräsen von Kupfer und Aluminium, um eine perfekt coplanare und bündige Oberfläche zu erzeugen. Dies ermöglicht dem Wärmequellen-Bauteil einen direkten, großflächigen Kontakt mit dem hochleitfähigen Kupferrohr und erzielt den niedrigstmöglichen Wärmewiderstand.

b. Tiefeinbettverfahren: Der zuverlässige Wächter

Runde Kupferrohre werden eingebettet und mit hochwärmeleitendem Epoxidharz umgossen. Die Kupferrohre behalten ihre runde Form, was eine höhere Druckbelastbarkeit bietet. Die Verfüllung bietet zusätzlichen Schutz und dient als Spannungspuffer, was eine höhere Zuverlässigkeit bedeutet – bei jedoch etwas höherem Wärmewiderstand im Vergleich zur Planfräsung.

c. Finale Wandstärke: Der entscheidende Parameter

Das Kernziel bei der Planfräsung ist die finale verbleibende Wandstärke des Kupferrohrs. Diese muss einen Ausgleich zwischen Leistung (dünn) und Zuverlässigkeit/Schutz gegen Durchfräsen (dick) finden und wird typischerweise in einem optimalen Bereich von 0.15–0.3 mm kontrolliert.

d. Ebenheit: Die Grundlage für guten Kontakt

Unabhängig vom verwendeten Verfahren ist die Ebenheit der Montagefläche (typische Anforderung: < 0.1 mm) eine harte Anforderung. Bereits mikrometergroße Unebenheiten müssen mit Wärmeleitpaste ausgeglichen werden. Eine unzureichende Ebenheit führt zu einem starken Anstieg des Kontaktwärmewiderstands und damit zum Versagen der Kühlung.

Wir werden regelmäßig Informationen und Technologien zu Wärmedesign und Leichtbau aktualisieren und mit Ihnen teilen. Vielen Dank für Ihr Interesse an Walmate.

Um die Reichweite und Kapazität von Elektrofahrzeugen zu erhöhen, wechselt das Hochvoltbatteriepackvon einem einlagigen Layout zu einer mehrschichtigen Stapelstruktur. Dieser Wandel erhöht signifikant die Energiedichte, bringt aber auch neue strukturelle Herausforderungen mit sich. Dieser Artikel beleuchtet drei Aspekte: Kernprobleme, Lösungsansätze und zukünftige technische Richtungen.

1 - Kernherausforderungen: Die mechanischen Herausforderungen des mehrschichtigen Stapelns

Die Erweiterung des Batteriepacksvon einer auf mehrere Lagen ist weit mehr als eine einfache Addition. Sie verändert die internen mechanischen Bedingungen und externen Lastpfadegrundlegend und bringt vier Kernherausforderungen mit sich:

a. Explosionsartiger Anstieg der vertikalen Lasten und Risiko des Materialkriechens

・In mehrschichtigen Strukturenaddiert sich das Gewicht der Zellen, Moduleund Strukturelementevon Schicht zu Schicht. Die unterste Schicht trägt eine weitaus höhere statische Drucklastals die oberste.

・Diese anhaltende hohe Druckspannungstellt eine ernsthafte Belastung für die Langzeiteigenschaftendes Materials dar, insbesondere für die Kriechbeständigkeit(langsame plastische Verformungdes Materials über Zeit unter konstanter Spannung).

・Wenn die zwischenschichtige Unterstützungoder Zellbefestigungselementekriechen, kann dies zu Vorspannkraftrelaxationführen, was die Zellzykluslebensdauerund Stabilität des Grenzflächenkontaktsbeeinträchtigt. Daher ist die Suche nach Materialien, die sowohl Leichtbauals auch hervorragende Kriecheigenschaftenvereinen, von entscheidender Bedeutung.

b. AusdehnungskraftÜberlagerungseffektund Strukturstabilität

・Lithium-Ionen-Batterienerzeugen aufgrund von Volumenänderungender Elektrodenmaterialienwährend des Lade- und Entladevorgangseinen "Atmungseffekt", der zur Zellausdehnungführt. In mehrschichtigen Stapelstrukturenaddieren sich die Ausdehnungskräftevon Schicht zu Schicht, was die unteren Moduleeinem enormen Druck aussetzt.

・Diese zyklische Belastungkann leicht Gehäuseaufwölbung, Dichtheitsversagen, Quetschen von Strukturelementen, Zellenkurzschlusssowie einen beschleunigten Batterieleistungsabfallverursachen. Eine effektive Kontrolle erfordert eingebaute Sensorenzur Echtzeitüberwachungin Kombination mit digitaler Simulation, um das strukturelle Optimierungsdesignzu steuern.

c. Der grundlegende Widerspruch zwischen Raumausnutzung und Energiedichte

・Die Bewältigung der Schwerkraftund Ausdehnungskrafterfordert verstärkende Strukturen(wie zusätzliche Querträger, dickere Blechstärken), dies beansprucht wertvollen Raum und erhöht das Gewicht, was im Widerspruch zum Kernziel der Steigerung der volumetrischen Energiedichteund gravimetrischen Energiedichtesteht.

・Die Lösung liegt in struktureller Optimierungund dem Einsatz hocheffizienter Materialien, was den Wandel des Batteriepackshin zu einem Multi-Material-Designvorantreibt.

d. Crashtlast Übertragungspfad und Upgrade der sicherheitstechnischen Redundanz

・Die zunehmende Höhedes Batteriepacksverschärft die mechanische Belastungbei Seitenaufpralloder Bodenaufprall; seine erhöhte Strukturverstärkt den Hebeleffektund stellt höhere Anforderungen an die Festigkeit der Verbindungspunkteund die eigene Steifigkeitdes Batteriepacks.

・Es müssen schlagfeste Materialienund integriertes Designeingesetzt werden, um Kraftleitungund Energieabsorptionzu optimieren, um die Zellensicherheitunter Extrembedingungenzu gewährleisten. Dies treibt die Entwicklung der Batterie-Fahrzeug-Integration(CTC) Technologie voran, wodurch das Batteriepackzu einem integralen Bestandteil der Fahrzeugstrukturwird.

2 - Vergleichsanalyseer Strukturkonzepte

Um diesen Herausforderungen zu begegnen, hat die Industrie verschiedene innovative Ansätze erforscht:

a. Einstückiger Druckgussschale(One-piece Die-cast Tray)

・Vorteile: Hohe Integrationsgrad, reduziert die Anzahl der Teile, verbessert die gesamte Steifigkeit, Konsistenzund Dichtheit. Das Verfahrenunterstützt komplexe Geometrien, erleichtert die Integration von Kühlung, Versteifungsrippenund Befestigungspunkten. Die Gesamtstrukturbegünstigt das Management komplexer Spannungen.

・Herausforderungen: Das Druckgießenmehrschichtiger Rahmenstellt extrem hohe Anforderungen an Anlagen, Werkzeugeund Prozess, ist kostspielig. Reparatur nach einem Crashschwierig oder unmöglich. Die starre Gesamtstrukturkann an Flexibilitätmangeln, um differentielle Ausdehnungskräftezwischen den Schichtenzu managen.

b. Mehrstufiger modularer Rahmen(Multi-level Frame Modular)

・Vorteile: Flexibles Design und Herstellung, erleichtert Produktion, Wartungund Austausch。Natürlich geeignet für Multi-Material-Design,允许 für verschiedene EbenenLeistungund Kostenoptimiert werden. Nutzt das Konzept der "quasi-isotropen Schichtung" aus Verbundwerkstoffen, um das gesamte mechanische Antwortverhaltenzu optimieren und Spannungenzu verteilen.

・Herausforderungen: Viele Einzelteileund Verbindungselemente, komplexe Montage, kumulierte Toleranzenbeeinflussen Präzisionund Vorspannkraft。Zahlreiche Verbindungsschnittstellen(Schrauben, Nieten) sind potenzielle Schwachstellenund erhöhen das Gewicht.

c. Sandwichstruktur aus Hybridmaterialien(Hybrid Material Sandwich Structure)

・Vorteile: Hervorragende Leichtbaueffizienzund extrem hohe spezifische Steifigkeit(hochfeste Deckschichten+ leichte Kernmaterialienwie Schaum/Aluminiumwabe). Starke Biegefestigkeit, Kernmaterialbietet gleichzeitig Wärmedämmungund Energieabsorbierungseigenschaften, verbessert thermische Sicherheitund Crashsicherheit。Entspricht dem Trend zur multifunktionalen Integration.

・Herausforderungen: Herstellungsverfahrenkomplex, hohe Kosten. Die Haftfestigkeit der Grenzflächezwischen Deckschichtund Kernmaterialsowie deren Langzeitbeständigkeitsind entscheidend. Das Kernmaterialmuss über ausgezeichnete Druckkriechfestigkeitverfügen.

d. Bionische Wabenstruktur

・Vorteile: Theoretisch ideal für maximalen Leichtbau, hohe Steifigkeitund Druckfestigkeitdurch bionisches Design(Nachahmung der sechseckigenBienenwabe). Bietet gleichmäßige Unterstützung, starke Fähigkeit zur Schockabsorption.

・Herausforderungen: Herstellungextrem komplex und teuer, große Integrationsschwierigkeitenmit z.B. Kühlsystem。Derzeit größtenteils im Stadium der Frontforschung,kommerzielle Anwendungbraucht noch Zeit.

3 - Richtungen für Schlüsseltechnologiedurchbrüche

Zukünftige Schlüsseldurchbrüche zur Lösung der Design-Herausforderungendes mehrschichtigen Stapelnsliegen in:

a. Material- und Prozessinnovation für Leichtbau und Steifigkeitsbalance

・Materialien:Kontinuierliche Optimierung von CFRP, Aluminiumlegierungen, Magnesiumlegierungen; Entwicklung neuer multifunktionaler Polymereund Verbundwerkstoffemit geringem Kriechen, hoher Isolierung, guter Wärmeleitfähigkeit, einfacher Verarbeitbarkeit.

・Prozesse: Entwicklung fortschrittlicher Fügetechniken(Widerstandspunktschweißen, Laserschweißen, Ultraschallschweißen) für zuverlässige, leichte Multi-Material-Verbindungen.

Abbildung 1: Roboter-Laserschweißen des Batterietrays

b. Adaptives Management der Ausdehnungskraft

Der Ansatz verschiebt sich von "starrem Widerstand" zu "flexibler Anpassung", um dynamische Response-Systemezu schaffen, die die Zellewährend ihrer Lebensdauerin einer optimalen Spannungsumgebunghalten.

c. Zwischenschichtverbindung und Integrationsrevolution

・Verbindungstechnik: Entwicklung von Schraubenmechanischen Verbindungenhin zu StrukturklebstoffKlebenund fortschrittlichem Schweißenfür gleichmäßigere Spannungsverteilung, gute Dichtheitund Ermüdungsfestigkeit.

・Ultimative Integration: CTC/CTB(Cell-to-Chassis/Body) ist eine wichtige zukünftige Richtung für die Integrationdes Batteriepacks。Durch den Wegfall des separaten Gehäuseswerden Zellenoder Moduledirekt in das Chassisintegriert, wodurch der mehrschichtige Stapelselbst zum Fahrzeugstrukturelement(wie Querträgeroder Boden) wird, Raumbeschränkungenfundamental löst und die Batteriestrukturfunktionmaximiert. Die Umsetzung erfordert tiefe Zusammenarbeitin den Bereichen Batterie, Struktur, Thermomanagementund Sicherheitund ist die ultimative Formdes "Struktur-ist-Funktion"-Konzepts.

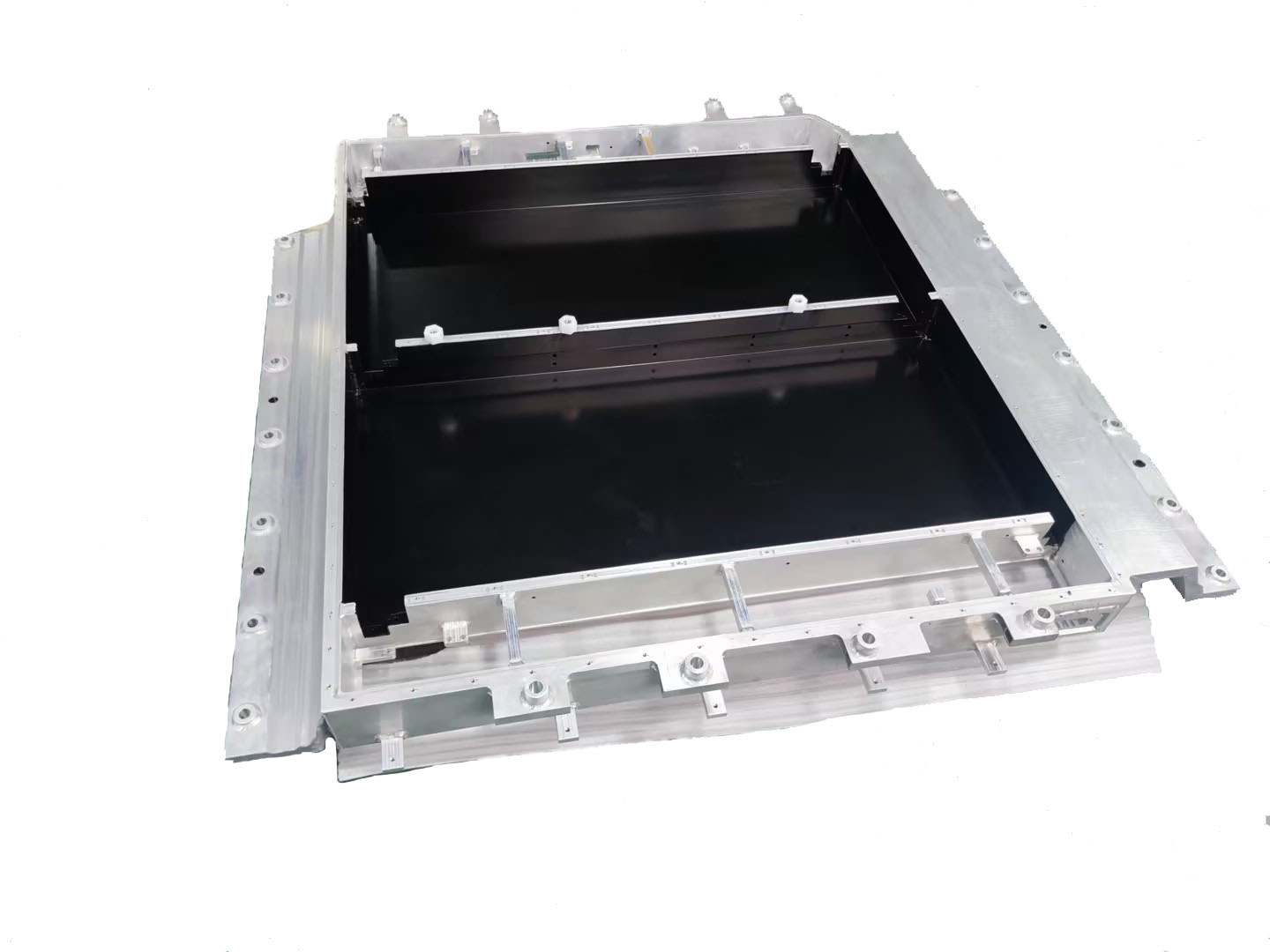

Abbildung 2: Batteriewannen

Mehrschichtiges Stapelnist eine unvermeidliche Wahl zur Erhöhung der Energiedichteder Batterie, bringt aber auch enorme Herausforderungen in Bezug auf Struktur, Ausdehnungskraftund Sicherheitmit sich. Der Ausweg liegt in Materialinnovation, optimierter bionischer Strukturund intelligentem Managementder Ausdehnungskraft。Letztendlich wird sich das Batteriepacktiefmit der Karosserieintegrierenund zu einem integrierten "Energie-Chassis" werden.

Wir werden regelmäßig Informationen und Technologien zu Wärmedesign und Leichtbau aktualisieren und mit Ihnen teilen. Vielen Dank für Ihr Interesse an Walmate.

Das zentrale Schlachtfeld elektrischer LKW: Tiefenanalyse der Batterieanordnung und Stapelungstechnik

Wenn ein mit Fracht beladener elektrischer LKW auf der Autobahn fährt, verbirgt sich das Geheimnis, das ihn hunderte von Kilometern antreibt, im Chassis und im Batteriegehäuse des Fahrzeugs. Heute, da die Welle der Elektrifizierung von Schwerlastkraftwagen die globale Logistikbranche erfasst, sind die Anordnung des Batteriesystems und die Stapelungstechnik zum entscheidenden Schlüssel für den Markterfolg geworden.

Abbildung 1: Flüssigkühlkonzept für Batterien elektrischer LKW

1-Batterieanordnung: Wie drei Konzepte die Form elektrischer LKW neu gestalten?

a. Rückenanordnung: Die agile Wahl für Kurzstreckentransporte

·Szenarioanpassung: Kurzstreckentransporte in geschlossenen Umgebungen wie Häfen, Minen, Stahlwerken

·Kernvorteil: Schnelle Batteriewechsel-Fähigkeit (konkrete Zeit muss praktisch verifiziert werden), steigert die Einsatzbereitschaft des Fahrzeugs

·Leistungsgrenzen: Begrenzte Batteriekapazität (branchenüblich <350 kWh), hoher Schwerpunkt beeinflusst die Stabilität bei hohen Geschwindigkeiten

·Raumnachteil: Belegt Laderaum oder Fahrerraum, verringert die Ladekapazität

b. Chassisanordnung: Der Reichweitenkönig für Langstreckenverkehre

·Kapazitätsdurchbruch: Batteriekapazität kann 500 kWh überschreiten (z.B. branchenbekanntes 513 kWh-Konzept)

·Raumzauber:Effiziente Nutzung des Chassisraums,vermeidet Laderaumbelegung

·Sicherheitsplus: Ultra-niedriger Schwerpunkt verbessert die Stabilität bei hohen Geschwindigkeiten

·Technologische Hürde: Chassis-Integration erfordert Entwicklung, höhere Anforderungen an Schutz und Thermomanagement

c. Seiten-Unterboden-Anordnung: Der Effizienzmotor für Wechselstromnetze

·Wechselstromrevolution: Seitlicher Batteriewechsel steigert die Operationseffizienz

·Raumbalance: Erhält vollen Laderaum, Reichweitenfähigkeit liegt zwischen Rücken- und Chassisanordnung

·Sicherheitsherausforderung: Erfordert Verstärkung der Seitenschutz-Struktur

2-Stapelungstechnik: Effiziente Integrationskonzepte für Schwerlastbatteriepacks

Mehrschichtige Stapelungstechnik wird zunehmend zum Schlüsselpfad zur Steigerung der Energiedichte:

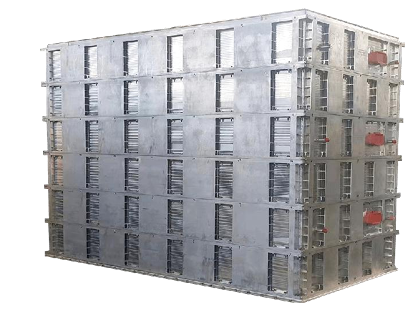

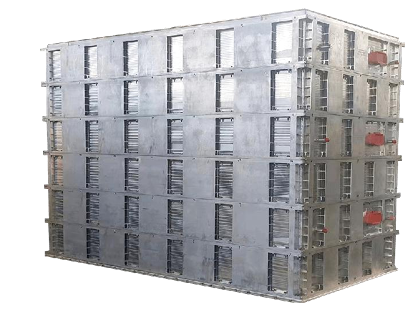

Abbildung 2: Gestapeltes Flüssigkühl-Integrationsgehäuse für Schwerlaster

a. Rahmenlose Direktstapelungstechnik:

·Zellen werden direkt gestapelt, reduzieren Strukturkomponenten

·Entfernt Module und Rahmen, Zellen werden direkt “Z-Richtung nahtlos gestapelt ”

·Deutlich verbesserte system Energiedichte · Unterstützt Schnelllade-Technologie (konkrete Leistung muss praktisch verifiziert werden)

b. Modul-zu-Chassis-Integration (z.B. MTB/CTC-Technologie)

· MTB-Technologie: Module direkt mit Rahmen verbunden, Volumennutzungsgrad(signifikant verbessert)

·Qilin Battery (CTP 3.0): 72% Volumennutzungsgrad, 255 Wh/kg Energiedichte

·CTC-Technologie: Zellen in Chassis

konstruktion integriert, Gewichtsreduzierung um 10%

c. Zellenform-Innovation (z.B. Blade-Battery)

·Flache Zellen eng angeordnet, Volumennutzungsgrad verbessert (von BYD veröffentlichte Daten >50%)

·Durchbricht Lithium-Eisen-Phosphat (LFP) Energiedichte-Flaschenhals

3-Zentrale technische Herausforderungen elektrischer LKW Herausforderung

1: Strukturelle Sicherheit

·Extreme Bedingungen: Seitenpfostenkollision stellt tödliche Bedrohung für Seitenanordnung dar

·Innovative Lösungsansätze: Hochfeste Aluminiumlegierungsgehäuse + Pufferstruktur; Kollisionssimulationsoptimierung (FEA); Mechanische Schocktests über nationalem Standard hinaus. Herausforderung

2: Thermomanagement

·Thermal runaway Alarm: Temperaturdifferenzkontrolle innerhalb des Packs ist entscheidend

·Technologiedurchbruch: Seitliche Kühlung mit Kühlplatten (Temperaturdifferenz<3°C); Direkte Kältemittelkühlungstechnik; Modellprädiktive Regelung (MPC) zur dynamischen Steuerung. Herausforderung

3: Vibrationsermüdung

· Versteckter Killer: Straßen-Vibrationen verursachen Strukturschäden

·Bewältigungsstrategie: Z-Richtung Stapelung optimiert Spannungsverteilung; Road-Spectrum Vibrationsprüfstandtests; Anwendung von hochdämpfenden Materialien.

4-Drei Trends bestimmen die aktuelle Entwicklung

·Chassisanordnung dominiert Mittel- und Langstreckenverkehre: Hohe Reichweite (>500 kWh) und niedriger Schwerpunkt-Eigenschaften werden bevorzugt

·CTC-Technologie Tiefenintegration: Batterie und Chassiskonstruktion verschmelzen, verbessern Raumausnutzung und Systemsteifigkeit

·Intelligentes Thermomanagement verbreitet sich: KI-Algorithmen ermöglichen präzise Temperaturregelung (Temperaturdifferenz <5°C), verlängern Batterielebensdauer

·Festkörperbatterie-Technologie entwickelt sich weiter: Halb-Festkörper-Batterien beschleunigen Kommerzialisierung, Potenzial konzentriert sich auf Sicherheit und Energiedichte-Steigerung

Wir werden regelmäßig Informationen und Technologien zu Wärmedesign und Leichtbau aktualisieren und mit Ihnen teilen. Vielen Dank für Ihr Interesse an Walmate.

Die Welle der elektrischen Lkw erfasst global die Logistikbranche und treibt die Ziele der "Doppelten Kohlenstoffneutralität" kräftig voran. Doch mit dem rasanten Anstieg der Reichweitenanforderungen gehen Batteriesysteme einher, deren Kapazität allgemein 500 kWh überschreitet und sogar auf 1000 kWh zusteuert. Dies gleicht dem Transport eines mobilen "Energieforts", dessen potenzielle thermische Sicherheitsrisiken ein bisher unerreichtes Ausmaß erreichen. Wenn die drei extremen Sicherheitskriterien "ultrahohe Kapazität", "extrem schnelle Wärmeausbreitung" (<2 Minuten) und "ultrahohe Kollisionsresistenz" (>1500 kJ) zusammenkommen, steht die Branche vor einer ernsthaften technologischen Kluft. Dieser Artikel analysiert diese Herausforderungen und untersucht systematische Lösungsansätze zum Aufbau einer spezifischen Sicherheitslinie für elektrische Lkw.

Abbildung 1: Dreischichtige Stapelung mit Kurzmesser-Schema

1-Ära der 500 kWh+: Chancen und Sicherheitsherausforderungen Hand in Hand

a. Kapazitätssprung als Mainstream: Um den Bedarf an schweren Langstreckentransporten zu decken, haben sich die Batteriekapazitäten elektrischer Lkw schnell von 200-300 kWh auf 600 kWh+ erhöht. Große Player bieten bereits Lösungen mit 500 kWh, 600 kWh und sogar 1000 kWh an, was den Beginn der Ära der ultrahohen Kapazitäten markiert.

b. Die Reife der LFP (Lithium-Eisenphosphat)-Batterietechnologie ist ein wichtiger Treiber. Ihre Vorteile in Sicherheit und Zyklenlebensdauer machen sie zur bevorzugten Wahl für schwere Lkw.

2-Die "drei großen Herausforderungen" unter extremen Sicherheitsanforderungen

a. Grenzkontrolle der Wärmeausbreitung (<2 Minuten):

· Kernziel:

Sicherheitsdesigns müssen die Wärmeausbreitung verzögern oder blockieren, um ein Zeitfenster für Flucht und Rettung zu schaffen (z. B. die 5-Minuten-Warnung nach der nationalen Norm GB 38031-2020).

· Ernste Realität:

In hochdichten Batterien mit 500 kWh+ kann die enorme Energie eines thermischen Durchgehens einer einzelnen Zelle leicht eine katastrophale Kettenreaktion auslösen. Praktische Tests zeigen eine extrem schnelle Wärmeausbreitung: Ein Fall dokumentierte 22 Sekunden bis zur vollständigen Erfassung des Batterieraums, 5 Sekunden bis zur Entzündung benachbarter Module und minimale Ausbreitungszeiten zwischen Modulen von nur 44 Sekunden.

· Kernschwierigkeit und Lücke:

Wie kann die Wärmeausbreitung zwischen Modulen effektiv auf über 2 Minuten begrenzt werden?

Bisher gibt es keine kommerziellen Lkw-Systeme, die öffentlich diese strenge Anforderung erfüllen und verifizieren können.

b. Hohe strukturelle Kollisionsresistenz (>1500 kJ):

· Kernanforderung:

Die Kollisionsenergie eines beladenen Lkw übersteigt bei Weitem die von Pkw und liegt leicht über 1500 kJ. Als tragendes Chassiselement muss das Batteriepaket ultrahohe Festigkeit aufweisen und nach einem Aufprall intakt bleiben, um Schäden an den inneren Zellen und thermisches Durchgehen zu verhindern.

· Ernste Realität:

Aktuelle nationale und internationale Standards (z. B. GB/T 31467.3-2015, UNECE R100) definieren die Testschwellenwerte für Kollisionsenergie bei Lkw-Batterien unklar oder zu niedrig. Öffentlich zugängliche Zertifizierungsdaten für Systeme, die 1500 kJ standhalten, sind äußerst selten. Obwohl es Simulationen mit höheren Energien gibt (z. B. 2500 kJ), bleibt die vollständige Systemvalidierung eine enorme Herausforderung.

· Kernschwierigkeit und Lücke:

Es mangelt an klaren Standards für den Schutz gegen hohe Kollisionsenergien und an ausreichend validierten Lösungen.

c. Risiko sekundärer Katastrophenketten (Ladungsexplosion & Straßenlähmung):

· Ladungsexplosionsrisiko:

Die Hochtemperaturflammen eines thermischen Batteriedurchgehens können leicht die Ladung entzünden (insbesondere Gefahrgüter) und eine Desasterkette auslösen: "Batteriedurchgehen → Ladungsbrand → Explosion".

· Straßenlähmungsrisiko:

Lithiumbatteriebrände sind schwer zu löschen (erfordern große Mengen an kontinuierlichem Kühlwasser) und neigen zum Wiederentflammen. Ein brennender Lkw mit mehreren Tonnen Gewicht auf Straßen oder in Tunneln erfordert komplexe Rettungsmaßnahmen (Hochspannungsabschaltung, Schutz vor Giftgasen) und ist zeitaufwendig (kann Stunden dauern, Auswirkungen bis zu 24 Stunden anhalten), was leicht zu schweren Verkehrsstörungen und großen gesellschaftlichen Auswirkungen führt.

· Kernschwierigkeit und Lücke:

Es fehlen quantitative Standards für die Räumungszeiten von Straßen und effiziente Notfallsysteme für solche Fälle.

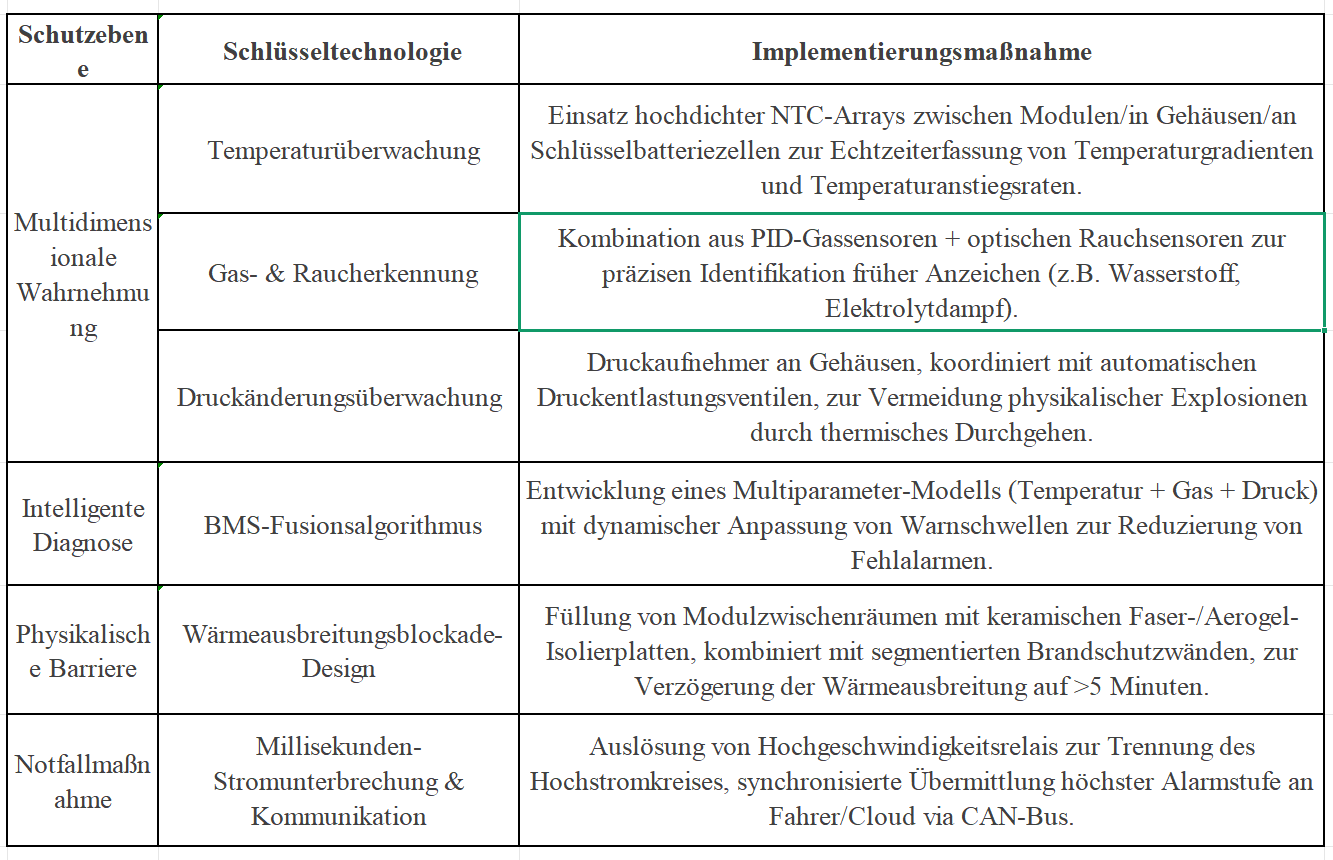

3-Aufbau der Sicherheitslinie: Design eines Warnsystems für thermische Ereignisse – Vierfaches Schutznetz

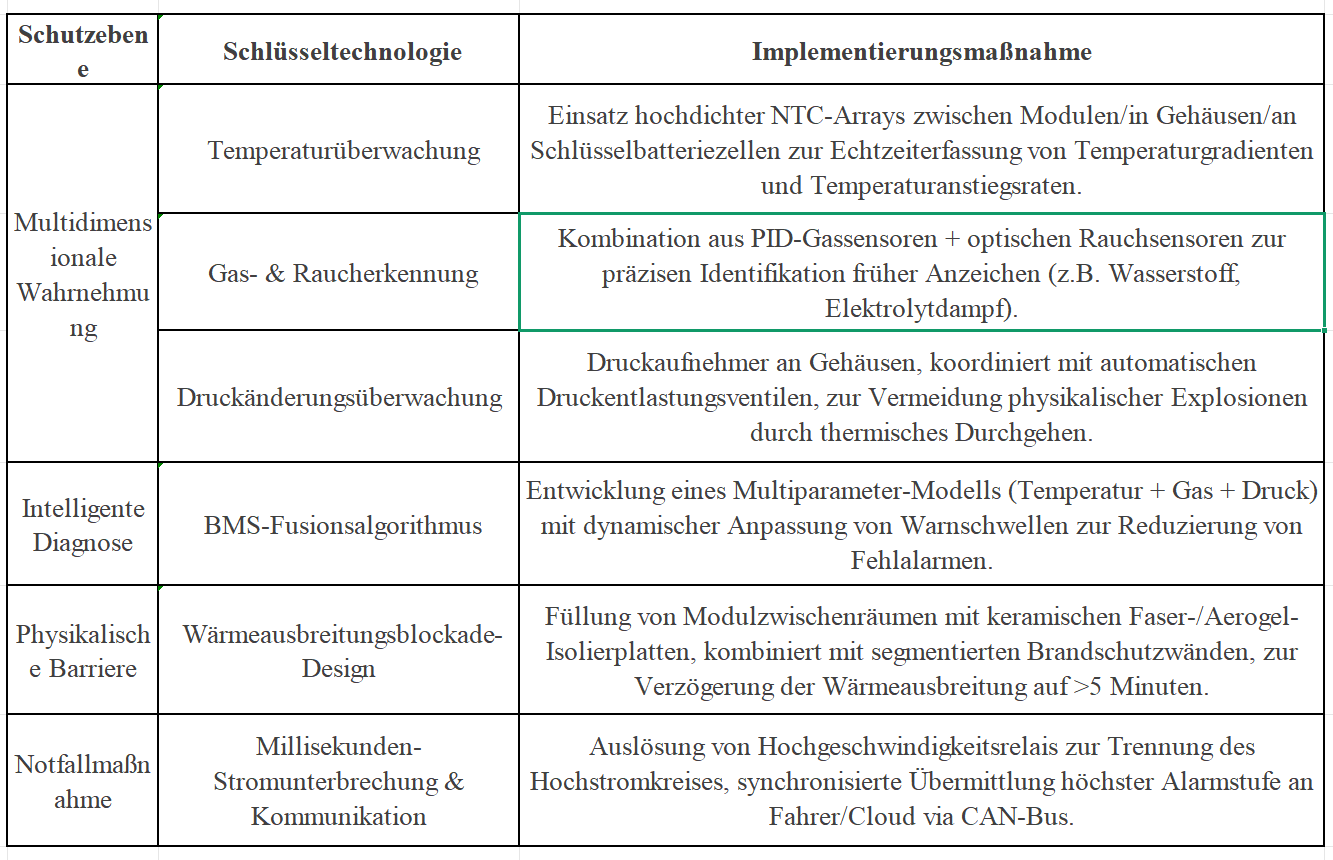

Tabelle 1: Vollständige Schutzstrategie "Wahrnehmung – Analyse – Blockierung – Reaktion"

4-Begleitende Wärmemanagement-Lösungen: Stärkung des Warnsystems

Flüssigkühlung: Integrierte effiziente Kühlplatten beseitigen lokale Hotspots und halten den Temperaturunterschied zwischen Zellen unter 3°C.

Modulares Design: Unabhängige, demontierbare Modulstrukturen ermöglichen den schnellen Austausch defekter Einheiten.

Intelligente Überwachungsplattform: Echtzeitanalyse des Batteriezustands in der Cloud, automatische Warnmeldungen an das Wartungsteam.

Wir werden regelmäßig Informationen und Technologien zu Wärmedesign und Leichtbau aktualisieren und mit Ihnen teilen. Vielen Dank für Ihr Interesse an Walmate.

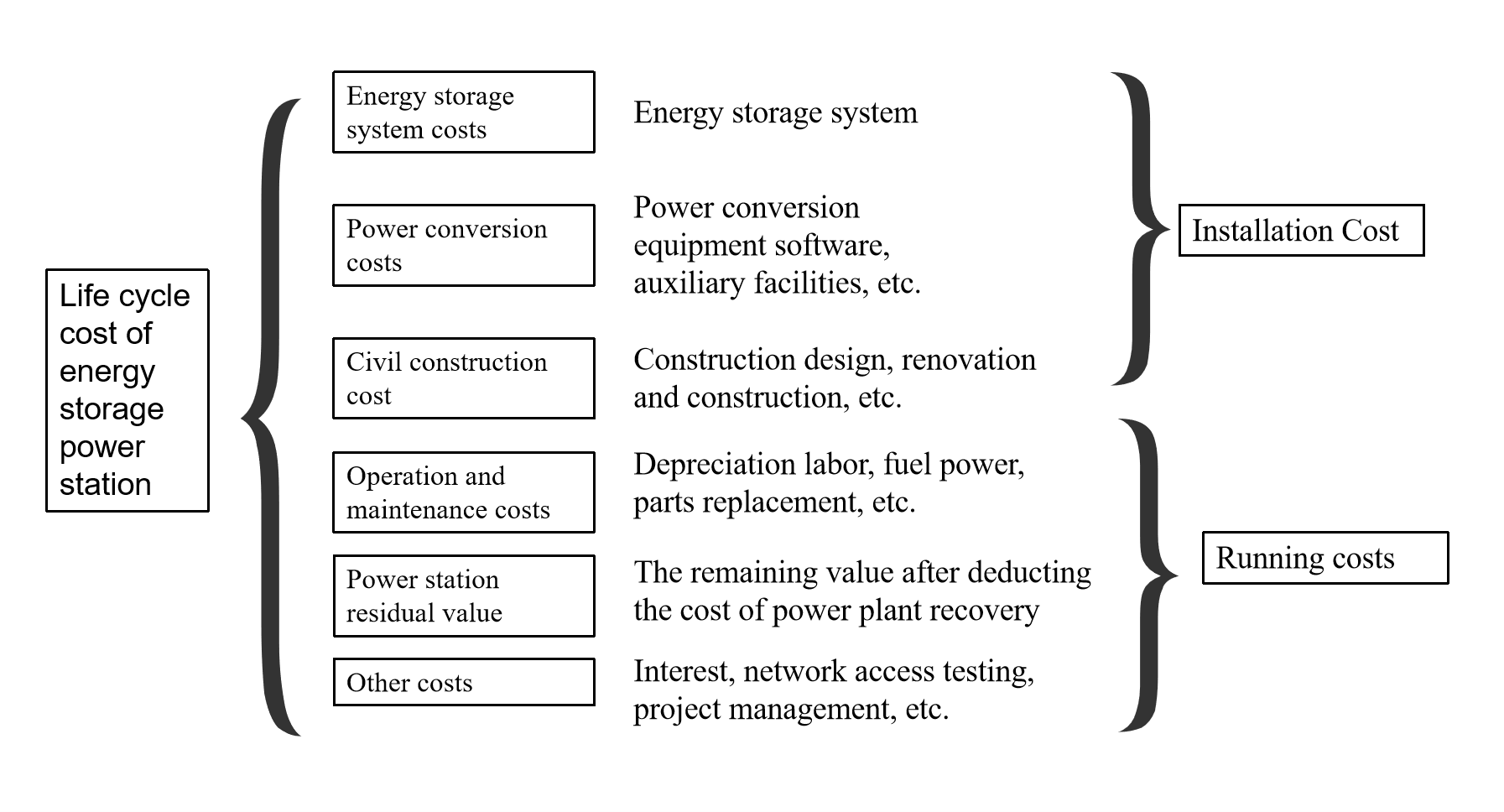

Im Markt für schwere Elektro-Lkw wird die „Batteriekapazitätsaufstockung“ zum Schlüsselbegriff: Die Batteriekapazität von Hauptmodellen überschreitet 370 kWh, und Modelle mit über 600 kWh werden immer häufiger vorgestellt. Dies ist nicht nur ein technischer Fortschritt, sondern auch eine klare Ansage der Branche an den Markt für Fernverkehrslogistik – durch die Erhöhung der Reichweite pro Ladung soll das Kernproblem der Nutzer, die „Reichweitenangst“, gelöst und die Gesamtbetriebskosten (TCO) optimiert werden. Dieser Artikel analysiert die zugrunde liegende Geschäftslogik und die technischen Lösungsansätze.

1-Geschäftslogik: Warum ist die „Batteriekapazitätsaufstockung“ notwendig?

a. Szenariogetriebene Notwendigkeit

· Geschlossene Szenarien (kurze Strecken, hohe Frequenz): Häfen, Minen etc. setzen auf Batteriewechsel (3-5 Minuten Ladezeit), wobei 280-kWh-Batterien ausreichen.

· Fernverkehrslogistik (Langstreckentransport): Macht 70 % des Frachtaufkommens aus und erfordert Reichweiten von über 500 km pro Ladung. 600-kWh+-Batterien werden zum „Schlüssel“ für diesen Markt.

b. Wirtschaftliche Abwägung der TCO

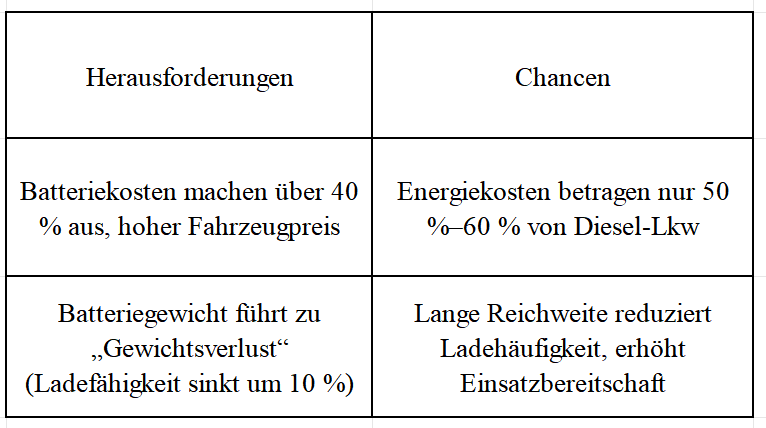

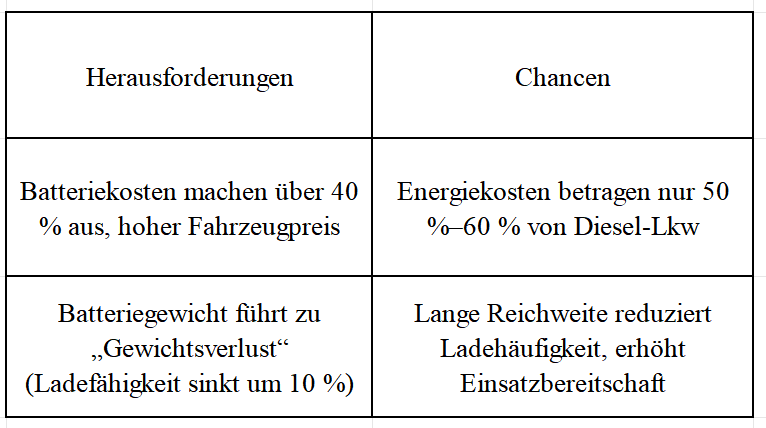

Tabelle 1: Herausforderungen und Chancen von elektrischen Schwerlast-Lkw

Wichtige Erkenntnis: Bei täglichen Fahrleistungen über 300 km sind schwere Elektro-Lkw mit Batteriewechsel wirtschaftlicher als Diesel-Lkw.

b. Modellinnovation: Lösung der Kostenproblematik

· Batteriemiete (BaaS): Nutzer kaufen das „nackte Fahrzeug“ und mieten die Batterie (5.000–9.000 Yuan/Monat), wodurch die Anschaffungskosten um 30 % sinken.

· Batteriewechseldienst: Servicegebühr von 0,2–0,5 Yuan pro kWh, Gesamtenergiekosten von ca. 2,73 Yuan/km (nahe an Diesel-Lkw mit 2,8 Yuan).

· Praxistest: Bei 50 Fahrzeugwechseln pro Tag kann sich die Amortisationszeit auf 5 Jahre verkürzen (IRR von 13,1 %).

2-Technische Lösungen: Wie lassen sich Reichweite und Eigengewicht ausbalancieren?

a. Kompromisse bei der Raumnutzung: Chassis gegen Platz

· Um zu verhindern, dass Batterien den Laderaum verkleinern, optimiert die Branche die Batterieanordnung. Beispielsweise werden Batterien ins Fahrgestell integriert (anstatt sie traditionell aufzuhängen), um Laderaum freizugeben, den Schwerpunkt zu senken und den Energieverbrauch zu verbessern.

· Nachteil: Geringere Bodenfreiheit und eingeschränkte Universalität des Chassis-Designs.

b. Kompromisse in der Materialwissenschaft: Energiedichte gegen Gewicht

· Der Schlüssel zur Gewichtsreduzierung liegt in der Steigerung der Batterieenergiedichte (mehr Energie pro Gewichtseinheit). Höhere Energiedichte macht Batterien leichter oder erhöht die Reichweite bei gleichem Gewicht.

· Kernpunkt: Innovationen bei Batteriematerialien (z.B. hoch nickelhaltige Kathoden, Silizium-Kohlenstoff-Anoden).

· Nachteil: Höhere Energiedichte geht oft mit Sicherheitsrisiken, kürzerer Lebensdauer, höheren Kosten und geringerer Schnellladefähigkeit einher – eine schwierige Abwägung.

c. Kompromisse im Geschäftsmodell: Netzwerk gegen Einzelfahrzeug

· Der Batteriewechselmodus für schwere Elektro-Lkw verlagert den Druck unbegrenzter Reichweite vom Einzelfahrzeug auf das Wechselnetzwerk. Durch dichte Stationen entlang der Strecke müssen Fahrzeuge nur genug Energie für die nächste Station mitführen, nicht für die gesamte Strecke.

· Effekt: Geringere Anforderungen an die Einzelbatteriekapazität, wodurch die Batterielast „angemessener“ wird.

d. Restwertmanagement: Die zentrale Hürde von BaaS

Batteriebanken müssen Fähigkeiten für den gesamten Lebenszyklus aufbauen: Gesundheitsüberwachung (SOH), stufenweise Nutzung, Recyclingsysteme.

Abbildung 1: Batterie-Pack-Gehäuse für Schwerlast-Lkw

3-Zukunftstrends: Von der „Kapazitätsaufstockung“ zur „effizienten Energienutzung“

a. Technische Weiterentwicklung: Festkörperbatterien werden die Energiedichte steigern und das Gleichgewicht zwischen Eigengewicht und Reichweite neu definieren.

b. Ladeinfrastruktur: Standardisierung des Batteriewechsels und Netzkoordination (z.B. Lastspitzenausgleich) sind entscheidend für die Skalierung.

c. Wettbewerb der Technologien: Wasserstoff-Lkw bleiben im Fern- und Schwerlastbereich eine Alternative.

Stufenweise Strategie, langfristige Entwicklung

Die „Batteriekapazitätsaufstockung“ ist eine notwendige Wahl für schwere Elektro-Lkw im Fernverkehr und spiegelt die dynamische Balance zwischen Marktanforderungen und technischer Realität wider. Mit Fortschritten in der Batterietechnik und Geschäftsmodellen wird sich die Branche vom „Wettlauf um Kapazität“ zum „Wettlauf um Effizienz“ entwickeln. Derzeit treibt sie den Wandel schwerer Elektro-Lkw in China von einer „Nischenlösung“ hin zum „Mainstream“ voran.

Wir werden regelmäßig Informationen und Technologien zu Wärmedesign und Leichtbau aktualisieren und mit Ihnen teilen. Vielen Dank für Ihr Interesse an Walmate.

Schwere Lastwagen, als Kernkraft der Straßengüterlogistik, machen die Sicherheit, Zuverlässigkeit und Wirtschaftlichkeit ihrer Batteriesysteme zu einem technischen Fokus. Der Batterieträger, als Schlüsselbauteil zur Trägerung, Schutz und Verwaltung von Batteriemodulen, steht vor beispiellosen extremen Herausforderungen.

Abbildung1:Batterieträger für elektrische Schwerlastwagen

1-Extreme Herausforderungen für Schwerlastwagen-Träger

a.Strenge Anforderungen an die mechanische Dauerhaftigkeit: Vibration, Stoß und eine Lebensdauer von Millionen von Kilometern

Die Designlebensdauer von Schwerlastwagen beträgt ≥ 1,5 Millionen Kilometer, was mehr als das Zehnfache von Pkw ist. Der Batterieträger muss während dieser "gesamten

Lebensdauer" kontinuierlich drei Arten extremer mechanischer Belastungen standhalten:

·Hochfrequente zufällige Vibrationen: Wenn das Fahrzeug beladen über unbefestigte, bauliche oder pothöfige Straßen fährt, erzeugt das Fahrgestell zufällige Vibrationen in einem breiten Frequenzband von 5 Hz bis 2 kHz. Diese Vibrationen stellen nicht nur die Ermüdungsgrenze des Hauptrahmens des Trägers auf die Probe, sondern induzieren auch Mikrorisse in Spannungskonzentrationsbereichen wie Schweißnähten, Bolzenlöchern und Umbiegungen, die zu Ausgangspunkten von Ausfällen werden.

·Hohe g-instantane Stöße: Tiefe Schlaglöcher auf der Straße, Notbremsungen oder Abstürze beim Be- und Entladen können in Millisekunden Beschleunigungen von mehr als 50 g erzeugen. Der Träger muss Energie in einem Augenblick absorbieren/verteilen, um zu verhindern, dass die Zellen verschoben, kurzgeschlossen oder die Gehäuse gebrochen werden.

·Kumulative Ermüdungszerstörung: Millionen von Kilometern bedeuten Milliarden von Vibrationszyklen. Aluminium neigt unter wechselnden Spannungen dazu, Ermüdungsrisse zu entwickeln, die sich ausbreiten und schließlich zu strukturellen Brüchen führen. Die Kernaufgabe des Designs besteht darin, durch Topologieoptimierung, lokale Verstärkung, Mischung verschiedener Materialien und Prozesskontrolle, die Lebensdauer der Rissentstehung bis zum Ausscheiden des Fahrzeugs zu verzögern.

b. Komplexe Herausforderungen im Thermomanagement und Wärmekreislauf

Aufgrund der extrem hohen Kapazität (mehrere hundert kWh) und des Hochleistungs-Lade- und Entladevorgangs erzeugen Schwerlastwagen-Batteriepakete enorme Wärmemengen, und sie werden in Umgebungen von der Tundra bis zum Tropengebiet betrieben, was extremen Temperaturunterschieden ausgesetzt ist.

Kontrolle über einen breiten Temperaturbereich: Der Träger und das Thermomanagementsystem müssen die Zellentemperatur genau im optimalen Bereich von 25-40°C halten, bei Umgebungstemperaturen von -40°C bis +85°C, und die Temperaturdifferenz zwischen einzelnen Zellen < 5°C betragen.

Starker Spannungskreislauf: In Laborbeschleunigungsalterungstests müssen Tausende von heftigen Temperaturwechselzyklen von -40°C ↔ 85°C standgehalten werden (Rate von 5-15°C/min, Verweilzeit an Extremwerten 5-15 Minuten). Dieser Prozess verursacht wiederholte thermische Ausdehnung und Kontraktion an Materialgrenzflächen (Aluminiumlegierung/Dichtkleber/Kunststoffteile), was eine schwere Prüfung für die Zuverlässigkeit von Schweiß- und Klebestellen integrierter Kühlleitungen darstellt.

2-Hauptstrom-Materialkonzepte und Technologien zur multifunktionalen Integration

Um diese Herausforderungen zu bewältigen hat die Branche in Bezug auf Materialauswahl und Designkonzepte eine Technologieentwicklung verfolgt, die auf hochfesten

Aluminiumlegierungen basiert und sich zu einer hohen Integration von Funktionen weiterentwickelt.

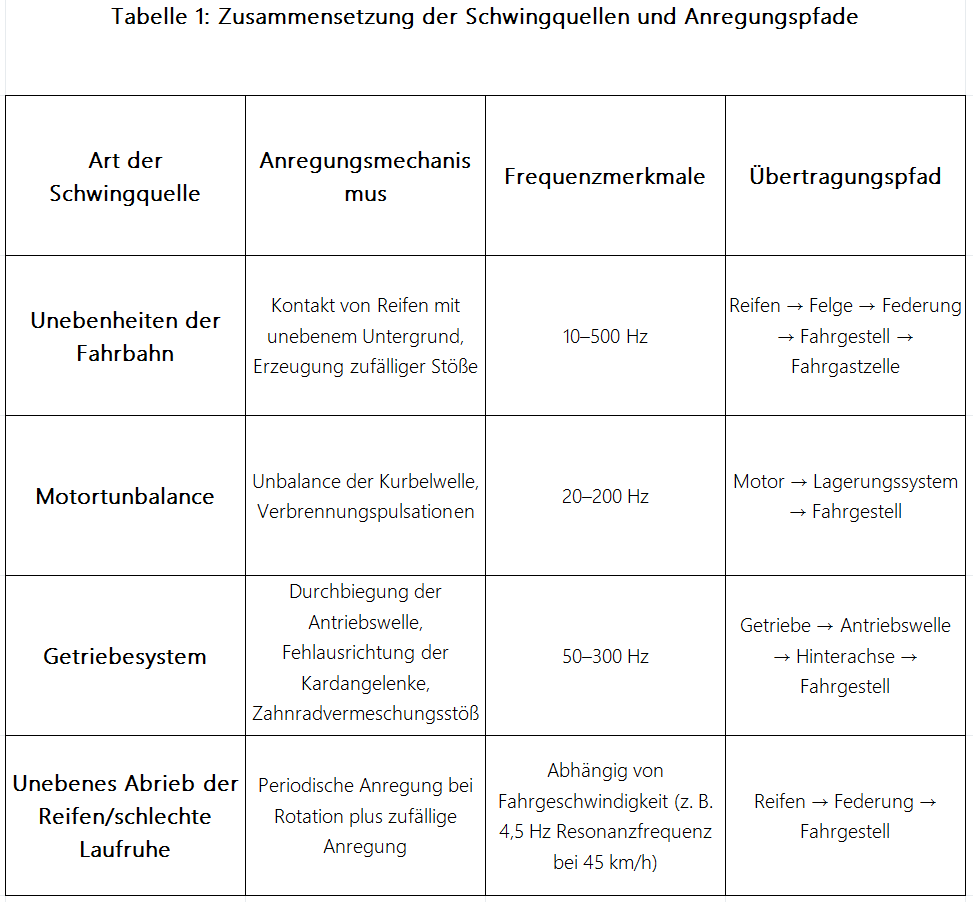

a. Kernmaterialauswahl: Die Vorherrschaft der 6xxx-Serie Aluminiumlegierungen

Im Wettbewerb mit Stahl, Magnesiumlegierungen und Verbundwerkstoffen hat die 6xxx-Serie (Al-Mg-Si) Aluminiumlegierungen dank ihrer hervorragenden Gesamteigenschaften, reifen Fertigungsprozessen und hoher Kosteneffizienz den Status als "Hauptstrom" Material für Schwerlastwagen-Batterieträger erreicht.

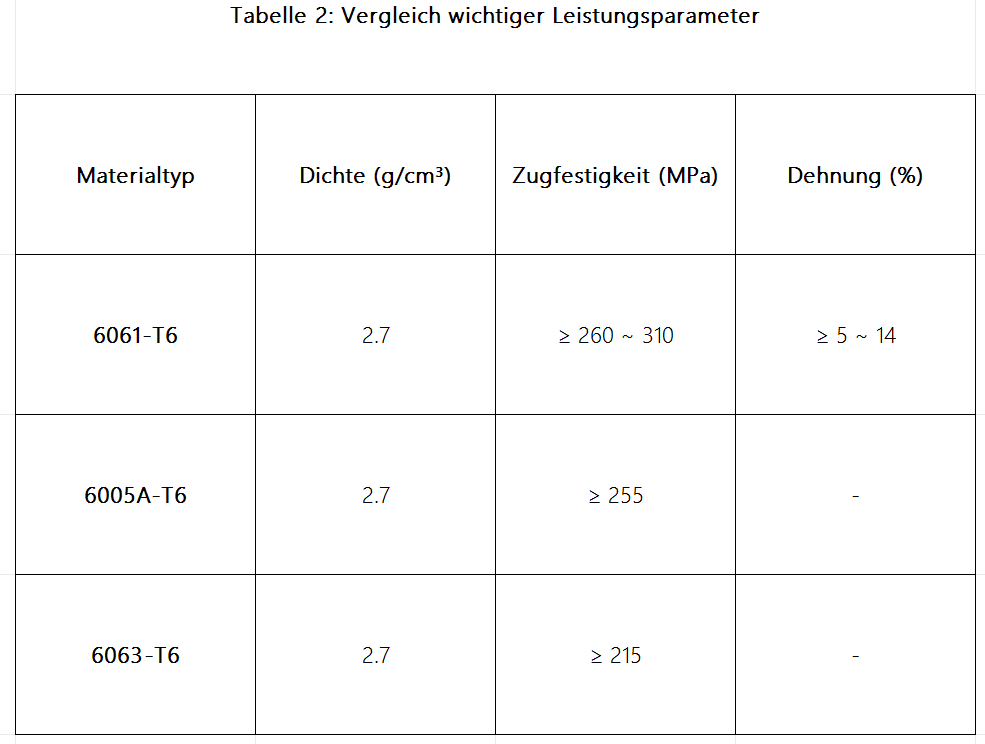

Haupttypen und Eigenschaften:

6061-T6: Dies ist der am weitesten verbreitete Typ, bekannt für seine hervorragende Festigkeit, gute Schweißbarkeit und Korrosionsbeständigkeit.

6005A-T6 und 6063-T6: Als ergänzende Optionen weisen sie ebenfalls gute Extrusionseigenschaften auf und eignen sich für Bauteile mit etwas geringeren Festigkeitsanforderungen.

b. Wandel des Designkonzepts: Thermomanagement und Strukturintegritätsüberwachung

Das Designkonzept moderner Schwerlastwagen-Batterieträger hat sich grundlegend verändert: Anstatt sich auf einen "Trägerkörper" zu beschränken, der physische Unterstützung bietet, hat er sich zu einer hochintegrierten "intelligenten Temperaturregelplattform" weiterentwickelt. Dieser Trend zeigt sich hauptsächlich in zwei technischen Richtungen:

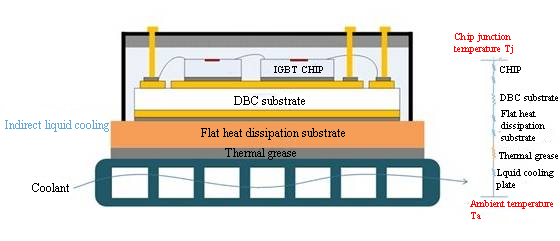

Effiziente Integration des Thermomanagements (reife Anwendung):Dies ist derzeit das am reifsten entwickelte und am weitesten verbreitete Integrationsgebiet. Der Kerngedanke besteht darin, die Kühlfunktion direkt in das Strukturdesign des Trägers zu integrieren, um ein effizientes und kompaktes Thermomanagement zu erreichen.

Erforschung der Strukturintegritätsüberwachung (SHM) (frühe Phase): Ziel dieser Technologie ist es, potenzielle strukturelle Schäden (wie Risse, Verformungen) am Träger während der langfristigen Nutzung zu warnen. Sie befindet sich noch in der Validierungs- und Laborforschungsphase und fehlt an Fällen von großskaliger kommerzieller Einsatz sowie ausreichenden Daten zur Langzeitbetriebszuverlässigkeit.

3-Analyse der Kernfertigungsprozessroute

Die Fertigungsprozesse von Schwerlastwagen-Batterieträgern bestimmen direkt ihre Kosten, Leistung und Produktionseffizienz. Der derzeitige Hauptstromweg basiert auf der Kombination aus Aluminiumprofil-Extrusion und Reibschweißung (FSW) als Kernkomponenten, die sich perfekt an die Leistungsanforderungen von Schwerlastwagen-Trägern und das derzeitige Produktionsmodell mit kleinen und mittleren Losgrößen anpassen lässt.

a. Aluminium-Extrusion: Dieses Verfahren bildet durch Pressen von Aluminiumbarren mit Formwerkzeugen langgestreckte Bauteile (Querträger/Längsträger usw.) und ist eine Kernfertigungstechnologie für Schwerlastwagen-Batterieträger. Der Vorteil liegt in niedrigen Werkzeugkosten und kurzen Entwicklungszeiten, insbesondere für die Produktion von großen nichtstandardisierten Teilen in kleinen Losgrößen. Allerdings müssen Schneiden, Bearbeiten und mehrere Schweißmontageschritte durchgeführt werden, was zu einem niedrigen Automatisierungsgrad, langsamen Produktionsrhythmus und einer geringeren Effizienz im Vergleich zum integrierten Gussverfahren führt.

b. Reibschweißung (FSW): Als Festphasenverbindungstechnik erreicht die Reibschweißung (FSW) eine hochfeste Schweißung von Aluminiumlegierungen durch Reibungswärme, die durch einen rotierenden Rührkopf erzeugt wird, und ist somit die erste Wahl für hochbelastete/dichte Verbindungen von Trägern. Die Festigkeit der Schweißnaht beträgt 80%-90% der Grundwerkstofffestigkeit, es gibt keine Poren- oder Rissdefekte, die geringe Wärmeverformung gewährleistet eine Dichtigkeit von IP67+ und sie ist umweltfreundlich. Ihre Einschränkung liegt darin, dass sie nur für Schweißungen auf ebenen oder einfachen gekrümmten Flächen geeignet ist.

Aluminium-Schwerlastwagen-Batterieträger haben sich von Hochfestigkeits-Leichtbau-Strukturen zu multifunktional integrierten Plattformen entwickelt. Jedoch führen die zunehmenden Funktionen zu Multi-Feld-Kopplungsausfällen, Prozesskomplexität und Zuverlässigkeitsherausforderungen. Zukünftige Durchbrüche müssen auf der koordinierten Innovation von Materialien-Prozessen-Systemen beruhen. Durch adaptive Schnittstellen und Digital Twin-Technologie soll eine sichere und nachhaltige Entwicklung intelligenter Träger erreicht werden.

Wir werden regelmäßig Informationen und Technologien zu Wärmedesign und Leichtbau aktualisieren und mit Ihnen teilen. Vielen Dank für Ihr Interesse an Walmate.

Kostengetriebene Revolution großer Zellen und Kühlherausforderungen:Die Energiespeicherindustrie durchläuft eine tiefgreifende Transformation, angetrieben von "Kostensenkung und Effizienzsteigerung" – dem rapiden Aufstieg der Technologie-Roadmap für große Zellen. 300Ah+ Zellen werden zunehmend Standard, während 500Ah und sogar höher leistungsfähige Zellen ihre Einrichtung beschleunigen. Diese Revolution steigert zwar die Systemenergiedichte und senkt die Kosten pro Wattstunde, bringt aber auch schwere Herausforderungen mit sich: Ein deutlicher Anstieg der Masse einzelner Zellen, ein starker Anstieg des Gesamtgewichts von Modulen/Paketen (Batteriepaketen), was den Tragdruck auf die unteren Stützstrukturen verdoppelt; eine größere Wärmeerzeugung und längere interne Wärmeübertragungswege stellen extreme Anforderungen an die Effizienz und Gleichmäßigkeit des Wärmemanagementsystems. Als Kern des Paketwärmemanagements stehen Flüssigkeitskühlplatten direkt unter dem Druck der Modernisierung.

Traditionelle "Dünnplattenabdeckungs"-Designs für Kühlplatten sind nicht länger nachhaltig. Unter den Beschränkungen von begrenztem Raum und strenger Kostenkontrolle müssen Kühlplatten ihre einzelne Funktion der Wärmeabfuhr übersteigen und sich zu einer Dreifaltigkeit von "Struktur-Funktion-Integration, maximaler Wärmeabfuhr-effizienz und Systemleichtbau" entwickeln. Dieser Artikel wird sich mit diesem fortschrittlichen Designpfad eingehend befassen.

1-Struktur-Funktion-Integration: Die "Tragrevolte" von Kühlplatten

Mit der deutlichen Zunahme der Zellmasse steigen die Lasten, die von der Gehäusebasisplatte und der Kühlplatte getragen werden, drastisch an. Die Gestaltung der Kühlplatte als tragendes Strukturbauteil ist der Schlüsselpunkt, um die Konflikte zwischen Gewicht, Kosten und Raum zu lösen.

a. Zum "Skelett" des Gehäuses werden: Integrierte tragende Basisplatte.

·Designkonzept: Die Kühlplatte ist nicht länger an der Gehäusebasisplatte befestigt, sondern wird selbst zur primären tragenden Struktur des Gehäuses.

·Kernvorteile: Signifikante Reduktion traditioneller Basisplatten und Halterungen, deutliche Senkung des Systemgewichts und der Materialkosten sowie Vereinfachung des Montageprozesses.

·Technische Anforderungen: Muss eine extrem hohe Biege-, Druck- und Stoßfestigkeit sowie Steifigkeit aufweisen.

b. "Stahlbewehrung" einbetten: Topologieoptimierung und Verstärkungsstrukturen

·Mechanik-getriebenes Design: Nutzung von CAE-Simulationen zur Topologieoptimierung, Integration von Versteifungsrippen usw. in nichtkritischen Wärmeabfuhrbereichen der Kühlplatte (z. B. Strömungskanallücken, Ränder).

·Hohe Materialeffizienz: Optimierte Konstruktion gewährleistet, dass das Material auf den kritischen Spannungswegen verteilt wird, überflüssiges Material entfernt wird und eine Gewichtsreduzierung bei gleichzeitiger Gewährleistung der Tragfähigkeit erreicht wird.

c. Modul-level Tragplattform: Komponenten konsolidieren

Großformatige, hochfeste Kühlplatten können direkt als Montagebasisplatte und tragendes Skelett für Module dienen. Zellen oder Module werden direkt darauf befestigt, wodurch zusätzliche Stützrahmen entfallen, die Struktur weiter vereinfacht und die volumetrische Effizienz verbessert werden.

2-Signifikante Verbesserung der Wärmeabfuhrleistung: Die Kunst des Ausgleichs zwischen Effizienz und Gleichmäßigkeit