El intercambio y la participación promueven el crecimiento

y trabajan juntos para el desarrollo común

En el camino hacia la potencia de cálculo de IA a exaescala, el supernodo CloudMatrix 384 de Huawei y el clúster GB200 NVL72 de NVIDIA se han convertido en dos cumbres tecnológicas de renombre mundial. No solo representan diferentes capacidades de integración de hardware, sino que también revelan profundamente dos filosofías fundamentales para construir sistemas de supercomputación.

Uno ha sido comparado con una "fiebre alta persistente", que enfrenta el desafío extremo de disipar el calor generado de manera constante y hermética por 384 chips en funcionamiento estable. El otro ha sido descrito como un "ataque epiléptico intermitente", que necesita domar el flujo de calor pulsante e intenso generado cuando 72 GPU de primer nivel trabajan en sincronía. Estas dos "etiologías" diferentes finalmente apuntan a "prescripciones" radicalmente distintas —es decir, soluciones de disipación de calor— y nos muestran claramente dos filosofías centrales de ingeniería en confrontación: sistemas de ingeniería deterministas versus innovación ágil en ecosistemas. Para cada empresa en la cadena de suministro, comprender esta confrontación es clave para definir su papel futuro.

1- El Origen de las Diferencias Centrales: La "Etiología" Determina la "Prescripción"

Desde el punto de partida del diseño, Huawei y NVIDIA tomaron caminos diferentes, lo que dio forma directamente a sus características térmicas distintivas:

Tabla 1: Comparación de las Características de la Fuente de Calor entre las Dos Rutas Tecnológicas

Esta diferencia entre "fiebre alta persistente" y "ataque epiléptico intermitente" no es en absoluto casual. Refleja que Huawei, como retador, optó por centrarse en el rendimiento total del sistema, persiguiendo a cualquier costo el límite extremo de densidad de cálculo dentro de un solo chasis; mientras que NVIDIA, como líder, tiene la tarea de construir un ecosistema que pueda colaborar de manera eficiente y sea fácil de adoptar, al tiempo que garantiza la ventaja de rendimiento absoluto de cada chip individual.

2- La Materialización de la Filosofía de Ingeniería: Dos Rutas de Refrigeración Líquida

Las dos filosofías de diseño diferentes encuentran su expresión más concentrada en las soluciones clave de refrigeración líquida, dando forma a la pila tecnológica completa desde el chip hasta la sala de servidores.

a. Huawei: La Práctica de Refrigeración Líquida de la Ingeniería de Sistemas Determinista

Esta es una filosofía de diseño de arriba hacia abajo, nacida para un objetivo determinista a nivel de sistema. Su núcleo consiste en implementar la disipación de calor como una parte clave de la infraestructura a través de una realización de ingeniería global, integrada y de alta confiabilidad, no meramente como un componente complementario.

Figura 1: Supernodo Huawei Ascend 384

· Precisión a Nivel de Chip y Conexión Confiable: Para garantizar que el calor del chip se transfiera eficientemente a la placa fría, Huawei se centra en la optimización de ingeniería de los materiales de interfaz. Aunque la información pública muestra que tienen reservas de patentes avanzadas en este campo (como cargas de carburo de silicio de alta esfericidad), sus soluciones específicas de aplicación en el supernodo no son públicas. Lo que es seguro es que sus soluciones buscan inevitablemente una resistencia térmica de interfaz extremadamente baja y una confiabilidad a largo plazo, para enfrentar el desafío de la "fiebre alta persistente".

· Redundancia a Nivel de Sistema y Control Inteligente: Adopta diseños redundantes como el suministro de líquido en anillo y desarrolla su propio controlador de gestión térmica (TMU) que actúa como el "centro neurálgico" del sistema. Este controlador puede lograr un cambio de 0 segundos entre tuberías y utiliza IA para la predicción de fallas, garantizando la determinabilidad y confiabilidad del enlace de disipación de calor de una manera definida por software. Esto es una manifestación típica de su pensamiento de ingeniería de sistemas.

· Integración de Infraestructura ("Integración Frío-Eléctrica"): A nivel de chasis, integra físicamente y gestiona de manera unificada la unidad de distribución de refrigeración líquida y la unidad de distribución de energía de alto voltaje. Este diseño "frío-eléctrico integrado" es la respuesta de ingeniería definitiva para enfrentar la densidad de potencia ultra alta por chasis, simplificar el despliegue y mejorar la eficiencia energética (reduciendo el PUE), representando la materialización de su diseño determinista desde el concepto hasta la forma física.

b. NVIDIA: El Marco de Refrigeración Líquida de la Innovación Ágil en Ecosistemas

Esta es una filosofía de diseño centrada en la GPU, que capacita al ecosistema global mediante la definición de estándares abiertos. Su núcleo es proporcionar un "plan" verificado que reduzca el umbral de aplicación para toda la industria y permita un despliegue escalable, eficiente y flexible.

· Estandarización a Nivel de Chip y Diseño de Referencia (VRD): NVIDIA proporciona diseños de referencia detallados para las GPU (como la serie Blackwell), definiendo claramente las interfaces de rendimiento como las dimensiones físicas de la placa fría, el consumo energético de diseño térmico (TDP), el flujo y la caída de presión. Esto equivale a proporcionar una "respuesta estándar" a todos los fabricantes de disipación de calor, encapsulando la complejidad dentro de componentes estándar y garantizando la compatibilidad y una línea base de calidad para los componentes fundamentales.

Figura 2: Módulo de servidor NVIDIA y placa fría líquida de microcanales

· Colaboración a Nivel de Ecosistema y Certificación de Soluciones: Colabora en profundidad con principales fabricantes de gestión térmica e infraestructura como Vertiv y Boyd para desarrollar y certificar conjuntamente soluciones de refrigeración líquida a nivel de chasis. Por ejemplo, la solución de chasis "Tier 2 Ready" de Vertiv es un producto pre-validado desarrollado basándose en el plan de NVIDIA, permitiendo a los operadores de centros de datos adquirir clústeres de refrigeración líquida listos para usar rápidamente, como si compraran equipos estándar.

· Capacitación mediante Gemelos Digitales y Aceleración del Despliegue: A través de la plataforma NVIDIA Omniverse, proporciona herramientas de gemelo digital y simulación para sistemas de refrigeración líquida de centros de datos. Los clientes pueden diseñar, validar y optimizar soluciones de disipación de calor en un entorno virtual, reduciendo enormemente el costo y el riesgo de la validación física y logrando una mayor agilidad desde el diseño hasta el despliegue.

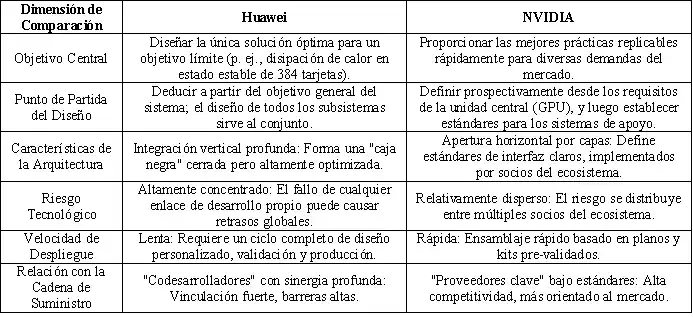

Para comprender más claramente estas dos rutas, comparamos sus diferencias centrales a continuación:

Tabla 2: Modelo Huawei vs. Modelo NVIDIA: Panorama de Diferencias Clave

3- La Ilustración Histórica y la Futura Fusión

Esta competencia entre las dos rutas no es un caso aislado en la historia de la tecnología. En esencia, es otra representación clásica de la innovación por integración de sistemas frente a la innovación por ecosistemas de plataforma. Huawei se asemeja a Apple en la era de Steve Jobs, buscando un control absoluto de la experiencia del producto desde el nivel superior hasta el más básico; mientras que NVIDIA se parece más al Android de Google actual, impulsando la prosperidad de todo un ecosistema mediante el establecimiento de estándares centrales (el sistema Android/la arquitectura GPU).

Para la industria, la tendencia futura no es que una ruta reemplace por completo a la otra, sino que es posible que surja un cierto grado de fusión:

· En proyectos nacionales o empresariales que buscan el rendimiento computacional extremo, el atractivo de la "ingeniería de sistemas determinista" sigue siendo fuerte.

· En el vasto mercado comercial de computación en la nube, la "innovación ágil en ecosistemas" continuará expandiéndose debido a sus ventajas de velocidad y costo.

· Las chispas de innovación pueden nacer en la zona de intersección: incorporar una personalización más profunda y una optimización colaborativa dentro de los estándares de ecosistemas abiertos.

4- Conclusión

Por lo tanto, la disputa en disipación de calor entre Huawei y NVIDIA es, en esencia, un enfrentamiento entre dos competencias centrales en la era de la IA: una busca lograr un rendimiento extremo y determinista a través de la integración profunda de la ingeniería de sistemas; la otra impulsa la innovación ágil y la rápida adopción masiva de la industria mediante la construcción de estándares abiertos y un ecosistema. Este enfrentamiento traza un camino claro para los participantes en la cadena de suministro: actuar como "fuerzas especiales", vinculándose profundamente para asaltar fortalezas específicas a nivel de sistema; o actuar como "ejército principal", integrándose en el ecosistema para explorar mercados en las vastas llanuras de los estándares. En última instancia, el resultado no solo depende de la tecnología en sí, sino también de la comprensión de la lógica de la evolución industrial y de una definición clara de la posición propia en el panorama futuro.

Actualizaremos periódicamente la información y las tecnologías relacionadas con el diseño térmico y la reducción de peso. Gracias por su interés en Walmate.